Заглавная страница Избранные статьи Случайная статья Познавательные статьи Новые добавления Обратная связь FAQ Написать работу КАТЕГОРИИ: ТОП 10 на сайте Приготовление дезинфицирующих растворов различной концентрацииТехника нижней прямой подачи мяча. Франко-прусская война (причины и последствия) Организация работы процедурного кабинета Смысловое и механическое запоминание, их место и роль в усвоении знаний Коммуникативные барьеры и пути их преодоления Обработка изделий медицинского назначения многократного применения Образцы текста публицистического стиля Четыре типа изменения баланса Задачи с ответами для Всероссийской олимпиады по праву

Мы поможем в написании ваших работ! ЗНАЕТЕ ЛИ ВЫ?

Влияние общества на человека

Приготовление дезинфицирующих растворов различной концентрации Практические работы по географии для 6 класса Организация работы процедурного кабинета Изменения в неживой природе осенью Уборка процедурного кабинета Сольфеджио. Все правила по сольфеджио Балочные системы. Определение реакций опор и моментов защемления |

Сигналы. Системы обработки сигналов.Содержание книги Похожие статьи вашей тематики

Поиск на нашем сайте Введение. Характерной чертой современного этапа развития науки, техники, экономики является широкое внедрение различных классов вычислительных машин. Разрабатываются новые вычислительные машины с улучшенными параметрами. В них уже закладываются некоторые принципы, характерные для построения и работы мозга – самого сложного и загадочного из известных нам творений природы. Критериями “умственных способностей” машин следующих поколений будут объём памяти, возможности образования логических цепей, способность к целенаправленному поведению в незнакомой информационной среде и другие не менее важные качества. Своими успехами техника хранения и переработки информации в значительной степени обязана успехам в области микроэлектроники, в особенности в разработке больших и сверхбольших интегральных схем. Однако интеграция элементов в силу ряда причин сегодня уже не обеспечивает положительного результата. Микроэлектроника в своём развитии может вскоре столкнуться с рядом проблем, которые станут тормозом на пути дальнейшего роста интеграции схем хранения и преобразования информации. Очевидно, перспективы развития элементной базы устройств памяти и переработки информации должны быть связаны с использованием новых сред, новых физических принципов и явлений, которые могут быть положены в основу создания устройств с качественно иными, более высокими технико-экономическими показателями. И на их основе можно будет создать машины сравнимые с мозгом человека не только по принципу построения, но и по количеству заполняемой информации.

Что такое информация? Там, где задаются вопросы, должны иметься спрашивающий и спрашиваемый, даже если это один и тот же человек. Чтобы ответить на вопрос “что такое информация?”, спрашиваемый должен сначала понять вопрос, а необходимым (но не достаточным) условием для этого является понимание всех содержащихся в вопросе слов. Употребляя выражение “информация”, спрашивающий должен его определить, чтобы спрашиваемый знал, о чём идёт речь. Но определение “информации” одновременно было бы и ответом на вопрос “что такое информация?” и, таким образом, сам вопрос оказался бы излишним. Другими словами, на вопрос “что такое информация?” следует вопрос “а что такое информация?”, что заводит нас в тупик. Возникают методологические сомнения, можно ли вообще ставить вопросы “что такое...?”. Если наименование или “определяемое” некоторого понятия Х обозначить через tX, а определяющее его выражение через dX, то вопрос “что такое информация?" – это вопрос типа “что такое tX?”, а ожидаемый ответ является предложением типа “ tX есть dX”. Чтобы связать некоторый термин с определением, имеются два пути: либо термину приписать определяющее выражение, либо определяющему выражению приписать термин. С формальной точки зрения безразлично, какой из путей избрать. С того момента, когда ответ “ tX есть dX” становится известным спрашивающему или спрашиваемому, может быть поставлен вопрос “что такое tX?”, и вопрос этот действительно часто ставится в учебной практике. Когда ответ известен спрашиваемому, мы имеем дело с “консультацией”, а когда он известен спрашивающему – с “экзаменом”. Очевидно, что каждое определение тоже состоит из терминов, которые в свою очередь могут требовать определения. Известно, что оценка количества информации основывается на законах теории вероятности. Это и понятно. Вероятность совершения какого-либо события представляет собой сумму вероятностей отдельных обстоятельств и ситуаций, определяющих событие. Пусть, например, имеется опыт, исход которого заранее неизвестен. Известно лишь множество N возможных исходов Х1, Х2,..., ХN и вероятности исходов Р(Х1), Р(Х2),..., Р(ХN). Количество информации в сообщении об исходе такого опыта равно:

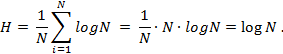

Это соотношение является одним из основных в теории информации и называется формулой Шеннона. Она выражает энтропию множества N вероятностей Р1, Р2,..., РN и в численном виде описывает “количество информации” (возможность выбора, неопределённость). Из приведённой формулы следует, что H=0 тогда и только тогда, когда одна из вероятностей равна единице (т.е. все остальные вероятности равны нулю). Это есть состояние определённости, или уверенности. Таким образом, утверждение, что из множества событий, каждое из которых может наступить с определённой вероятностью, одно действительно наступило, сводит неопределённость к нулю, что, по словам Шеннона, позволяет рассматривать величину H как “разумную количественную меру возможности выбора, или меру количества информации”. Если все исходы опыта равновероятны, то

Выбор единицы количества информации сводится к выбору основания логарифма. Если логарифм берётся при основании 2 и N=2, то

Эта единица количества информации получила название бит, и она соответствует утверждению, что произошло одно из двух равновероятных событий. В соответствии с этим количество информации в битах, получаемое при сообщении, что произошло одно из N равновероятных событий, выражается формулой, выведенной ещё раньше Хартли:

Мы видим, что понятие “количество информации” определено способом, не оставляющим места для размышлений над тем, “что такое количество информации”, так как оно получено путём разумного терминологического соглашения, основанного на математической формуле. С научной точки зрения подход является безупречным. Однако с самим термином “количество информации” связана некоторая неясность, ибо в неявном виде предполагается, что если известно, что такое количество информации, известно также, что такое информация. Теория информации до сих пор пока ещё не полностью обоснована, по меньшей мере, по двум причинам. Во-первых, она требует теоретического обоснования самого понятия информации. Во-вторых, да;t понятие количества информации не охватывает всех случаев, в которых требуется количественное описание информации. Дело в том, что для использования этого понятия нужно определить множество событий, которые могут произойти, и вероятности наступления каждого события. В то же время часто возникает необходимость количественного описания информации в условиях, когда множество событий точно не определено, а вероятности их наступления указать невозможно. Например, как описать количество информации в геометрическом утверждении, что один угол составляет половину другого. Ведь элементы геометрии вообще не “происходят”, это понятия абстрактные. В связи с такого рода неясностями возникает недоумение, почему, несмотря на существование теории информации, в обычных, чаще всего встречающихся на практике случаях из неё нельзя узнать, что такое информация, и даже то, каково в том или ином случае количество информации. Шеннон, наверное, отдавал себе отчёт в том, что понятие «информация» пока не определено и может ввести в заблуждение, поэтому назвал свою книгу “Математическая теория связи”. Употребляя слово «информация» в обычном смысле, можно сказать, что работа Шеннона касается больше передачи сигналов, несущих информацию, чем информации как таковой. Работа Шеннона больше имеет дело со связью, чем с трудно уловимым конечным результатом связи, которым собственно и является информация. Отец кибернетики Винер предложил следующее определение: “Информация – это обозначение содержания, черпаемого нами из внешнего мира в процессе нашего приспособления к нему и приведения в соответствии с ним нашего мышления”. К сожалению, это определение информации через ещё более неопределённое и лишённое общности понятие “содержание”. Понятие информации – не только центральное понятие теории информации, но также и одно из фундаментальных понятий кибернетики. Это самое трудное понятие для всякого, кто хочет вникнуть в проблемы кибернетики, и оно до сих пор не имеет точного определения. Исходя из задач технической теории передачи сообщений, вполне допустимо и даже уместно использовать суженное понятие информации типа “орёл” или “решка”, полученной в результате бросания монеты как испытания с равновероятными альтернативами. Таким образом, “один бит информации” – это информация, содержащаяся в кодовом знаке, принимающем лишь два значения при условии, что оба эти значения равновероятны. Любое сколь угодное сложное сообщение можно передать при помощи последовательности, построенной из двух различных символов, например из 1 и 0, которым могут соответствовать: 0 – отсутствие сигнала, 1 – наличие сигнала. Итак, информация передаётся сигналами.

Множества сигналов.

При графическом представлении сигналы изображаются сложной совокупностью точек – кривой в простой области – в двумерном пространстве. В отличие от этого в теории сигналов вводят более сложные пространства – пространства сигналов, в которых каждый сигнал изображается простейшим элементом – точкой. Рассмотрим сигнал как элемент множества S. Само множество определяется некоторым свойством P, которое есть утверждение, справедливое для любого элемента множества. Условно это изображается так:

Гармонические сигналы. Обозначим через Sс множество всех гармонических сигналов (синусоидальных), т.е.

Утверждение Re Z, Im Z – действительная, мнимая, часть числа Z. Часто свойство P для конкретного множества можно указать в другой форме, например с помощью порождающего гармоническую функцию дифференциального уравнения

Периодические сигналы. Через Sп(T) обозначим множество периодических сигналов с периодом T.

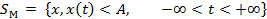

Ограниченные сигналы. Множество сигналов, мгновенные значения которых ограничены по величине некоторым вещественным положительным числом A, обозначается:

Ясно, что Сигналы с ограниченной энергией. О сигналах из множества

Сигналы ограниченной длительности. Пусть

Заметим, что

Имея дело с множествами сигналов, полезно применять две элементарные операции теории множеств: объединение, определяемое как

Операторы ∪и ∩ могут быть применены для получения разбиения множества на ряд непересекающихся подмножеств. Мы говорим, что совокупность множеств {S1,S2,S3,...} образуют разбиением множества S, если S = S1 ∪ S2 ∪ S3 ∪...; Si ∩ Sj = ∅ для i≠j

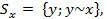

При разбитии множества обычно получают более удобные подмножества. Разбиение можно произвести с помощью отношения эквивалентности, и часто это наиболее подходящий способ получения разбиения. Мы говорим, что два элемента эквивалентны, x~y, если отношение эквивалентности ~ определено для всех пар элементов и удовлетворяет следующим свойствам: x~x для любого x (рефлексивность), x ~ y ⇒ y ~ x ( симметрия ), x~y и y~z ⇒ x~z (транзитивность). Каждое отношение эквивалентности естественным образом порождает разбиение множества на ряд подмножеств Sx, называемых множествами эквивалентности, причём Sx включает все элементы, эквивалентные х:

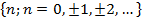

С другой стороны, любое разбиение порождает отношение эквивалентности. Возьмём пример, известный из теории чисел. Рассмотрим разбиение множества всех целых чисел

Соответствующее отношение эквивалентности

Если мы исключим подмножество сигналов

(*) Это разбиение широко используется в двоичных системах передачи сигналов, причём одно значение двоичной величины соответствует всем сигналам из S+, а другое – всем сигналам из S –. Блок-схема двоичной системы передачи сигналов в этом случае имеет вид:

Хотя передаваемые сигналы могут быть только двух типов, в множество принимаемых сигналов входят сигналы, разнообразные по форме из-за шума и других помех, вносимых в канал передачи. Наблюдатель судит о том, какой сигнал из заданного разбиения (*) был передан по сигналу на выходе ограничителя. Не имеет значения, к какому из множеств S+ или S– отнести сигналы из подмножества S0, так как вероятность их появления при приёме ничтожна. Другой тип устройства для приёма двоичных сигналов, обладающий большей помехоустойчивостью, использует опорный сигнал ζ для разбиения принятых сигналов на два подмножества. Разбиение на подмножества S1 и S2, соответствующее принятию решения о том, какой из сигналов x1, или x2 был передан, выполняется на принятых сигналах y по условию:

Приёмное устройство в этом случае имеет вид:

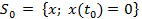

Устройство содержит умножитель, интегратор, прерыватель и пороговое устройство. Опорный сигнал и величину порога выбирают по специальным алгоритмам оптимизации. Ещё одна возможность различия сигналов состоит в подсчёте числа пересечений нулевого уровня за определённый промежуток времени. Мы задаём разбиение

Можно также получить конечное разбиение

Схема реализует передачу и приём (N+1) – буквенного алфавита, соответствующего заданному (**) разбиению.

Накопление информации.

Способность к накоплению и хранению информации, т.е. наличие памяти, – одно из важнейших свойств любой кибернетической системы, без которого немыслимо её целесообразное функционирование. Физическую систему называют запоминающим устройством или, в информационном смысле, каналом накопления, если она обладает способностью обеспечивать достаточно длительный временной интервал между моментами прихода и использования информации. Это значит, что сигнал St, относящийся к моменту времени t, может быть воспроизведён с помощью такой системы в любое произвольное время τ в виде сигнала Sτ. Простейшая системная модель, обладающая свойством памяти, состоит из запоминающей среды. Основное свойство такой среды заключается в способности фиксировать и сохранять во времени следы информационных воздействий, а затем при определённых условиях полностью или частично воспроизводить их. Под влиянием входных сигналов Sвх(t1) и сигнала адреса Sа(t1) формируется некоторое адекватное функциям Sвх(t1) и Sа(t1) состояние среды:

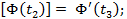

Для этого необходимо иметь некоторую систему элементов, состояние которых можно было бы изменять желаемым образом при помощи сигнала S(t). Эти изменения могут происходить либо непрерывно, либо скачкообразно. В первом случае говорят о запоминающих элементах аналогового типа, во втором – об элементах дискретного типа. Необходимый элементный состав запоминающей среды определяет способ представления информации. В вычислительной технике широко используются элементы памяти дискретного типа пригодные для запоминания двоичного кода. Такой выбор обусловлен тем, что в физическом мире наиболее просто реализуются системы, обладающие двумя устойчивыми состояниями. Соответственно запоминающая среда должна содержать набор бистабильных элементов, которые могут находиться в двух устойчивых состояниях. Таким образом, среда – носитель информации – должна хранить в виде следа Ф(t) навязанное ей состояние, которое в идеальном накопителе должно оставаться неизменным в течение всего данного промежутка времени хранения. Однако под влиянием внешних воздействий, а также внутренних процессов, свойственных всякой системе, к началу считывания информации состояние среды неизбежно изменяется.

Воспроизведение информации.

Считывание (воспроизведение) информации – заключительный этап процессов памяти. При нарушении воспроизведения поведение системы меняется так, как если бы память в ней отсутствовала. Для воспроизведения информации из памяти необходимо активизировать определённую группу запоминающих элементов, составляющих ячейку памяти. При этом активирующее воздействие должно иметь такую природу, чтобы запоминающие элементы могли под его влиянием вырабатывать сигнал, соответствующий своему состоянию. Кроме того, оно должно быть индифферентным – одинаковым для любой ячейки независимо от содержания информации, хранящейся в ней. Если состояние запоминающих элементов однозначно соответствует сигналу, пришедшему на вход записи, то эта информация будет воспроизведена. При использовании некоторых физических сред считывание приводит к разрушению хранящейся в ячейки информации. В этом случае после каждого считывания необходимо производить запись той же самой информации в ту же ячейку. Запись информации в какую-либо ячейку и её считывание (с восстановлением) из какой-либо ячейки памяти производится за время, называемое периодом обращения. Время, необходимое для считывания информации из ячейки памяти, называют временем выборки. Одной из характеристик систем памяти является метод поиска информации. Поиск информации, по сути дела, сводится к поиску соответствующих запоминающих элементов (ячеек). Тип поиска, при котором, происходит обращение к какой-либо ячейке ЗУ по её номеру независимо от содержания искомой информации, называется адресным. Информация может быть выбрана и по некоторым её признакам или по некоторой известной её части. Такой принцип поиска – его называют ассоциативным – характерен, в частности, для биологических систем. При этом на входе появляется некоторый ключ – стимул, а на выходе памяти формируется специальная ответная реакция, связанная с ключом. Как стимул, так и ответная реакция представляют собой сложные сигналы – образы.

Помимо этого на входе может быть указана дополнительная информация, с помощью, которой можно более точно конкретизировать элемент, подлежащий выборке. С созданием ассоциативных ЗУ коренным образом меняется структура вычислительных машин и по-новому осуществляется управление сложными сигналами.

Магнитная запись. Необходимость хранения больших массивов информации привела к использованию в ЗУ известного в технике принципа записи сигналов на магнитную поверхность. Физической основой магнитной записи сигналов является свойство ферромагнитных материалов сохранять состояние остаточной намагниченности.

Воспроизведение информации

сводится к преобразованию остаточного поля магнитного отпечатка в электрический сигнал с помощью МГ. При движении отпечатков носителя относительно МГ часть остаточного магнитного потока Фг отпечатка замыкается через её сердечник, в результате обеспечивается магнитная связь между отпечатком и обмоткой сердечника МГ. Так как магнитный поток изменяется во времени, то в обмотке возникает ЭДС – сигнал воспроизведения е(t), в общем виде определяемый в соответствии с законом эктромагнитной индукции Фарадея как:

Сигнал е(t) в основном определяется горизонтальной составляющей магнитного потока отпечатка, поэтому здесь и далее под потоком будем подразумевать его горизонтальную составляющую. Изменение магнитного потока отпечатка вызывается движением со скорростью Vн магнитного слоя относительно МГ. Если предположить, что в рассматриваемый момент времени граница отпечатка магнитного слоя находится на расстоянии

то выражение для ЭДС можно представить в виде:

Для определения величин Фг можно воспользоваться теоремей взаимности. Ток записи I вызывает поток Ф через произвольное сечение ds = b∙dy магнитного слоя, который перемагничивается полем Нх(х). В соответствии с теоремой взаимности тот же ток I, обтекая это сечение, вызывает идентичный поток Фг через сердечник МГ. Ток I, обтекающий сечение ds, может рассматриваться как сумма микротоков отдельных элементарных объёмов b∙dx∙dy, которая эквивалентна намагниченности Jz.

Таким образом, для единичного тока элементарный поток dФ’ при µотн=1 определяется как

Подставив значение

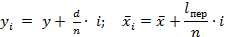

Предполагая, что знаком изменения намагниченности на участке носителя lпер линеен, определим

Учитывая что на других интервалах изменения намагниченности нет, имеем:

Координаты

Очевидно, что при lпер →0 и d→0,

Это выражение удобно использовать для практических расчётов, так как оно позволяет определить сигнал е(

Суммарный сигнал воспроизведения может быть получен в виде суммы сигналов еi от каждого тонкого слоя:

Покажем пример, когда магнитное покрытие “расслаивается” на три слоя:

Сравнивая показанные на рис. сигналы воспроизведения от наиболее близкого к МГ слоя е1 и удалённого слоя е3 можно сделать важный вывод: высокую разрешающую способность системы можно получить лишь при использовании тонких магнитных покрытий, малоудалённых от МГ. Это обстоятельство заставляет конструкторов и технологов постоянно решать задачу получения тонких и сверхтонких магнитных покрытий и создания системы «головка – носитель», всё более приближающейся к системам контактной записи. Выражение (*) для ЭДС удобно тем, что оно даёт возможность изучить влияние ряда конструктивных параметров – величины зазора МГ, формы полюсных наконечников и др. – на величину и форму сигнала воспроизведения. Если амплитуда сигнала е(

Следует подчеркнуть, что значение функции

Плотность магнитной записи.

Плотность записи информации Р – это степень использования поверхности носителя, выражаемая в битах, приходящихся на единицу площади поверхности носителя (например, на 1 мм²). Различают поперечную РП и продольную Рпр плотности записи информации: РП · Рпр = Р Поперечная плотность характеризуется числом дорожек записи, приходящихся на единицу длины, в направлении, перпендикулярном направлении записи. Продольная плотность записи определяется количеством бит информации приходящихся на единицу длины вдоль дорожки (в направлении записи). Рассмотрим основные причины, ограничивающие плотность записи информации на магнитный носитель. Ширина дорожки записи определяется в основном шириной набора сердечника МГ. Стремление уменьшить ширину дорожки ведёт, с одной стороны, к усложнению конструкции МГ при её миниатюризации, с другой – к уменьшению сигнала воспроизведения. На носителе дорожки разделяются некоторым промежутком, достаточным для того, чтобы ослабить в необходимой мере взаимное влияние соседних дорожек (уменьшить перекрёстные помехи). Если полезный сигнал воспроизведения линейно изменяется при уменьшении ширины дорожки, то сигнал помехи (отнеравномерности магнитного слоя, посторонних включений, краевых эффектов и т.д.) уменьшается лишь по закону квадратного корня, т.е. уменьшение ширины дорожки ведёт, как правило, к ухудшению отношения сигнал/помеха, являющемуся одним из основных параметров, определяющих надёжностные характеристики всей системы записи-воспроизведения. Для уменьшения влияния дорожек друг на друга может быть использовано туннельное стирание. В этом случае сигналограмма после записи проходит через “туннельную” головку, которая сужает запись, как бы подтирая её размытые края. На гибких носителях (МЛ, ГМД) ширина дорожки выбирается относительно большой (1-2 дорожки на 1 мм). Это обеспечивает получение удовлетворительного сигнала воспроизведения в условиях относительно невысокой линейной скорости носителя и даёт возможность снизить требования к стабильно

|

||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|

Последнее изменение этой страницы: 2016-04-19; просмотров: 535; Нарушение авторского права страницы; Мы поможем в написании вашей работы! infopedia.su Все материалы представленные на сайте исключительно с целью ознакомления читателями и не преследуют коммерческих целей или нарушение авторских прав. Обратная связь - 216.73.216.141 (0.016 с.) |

и

и

означает, что эти параметры могут произвольно выбираться из множества всех действительных чисел

означает, что эти параметры могут произвольно выбираться из множества всех действительных чисел  .

.

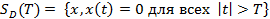

– это множество сигналов, которые равны нулю за пределами интервала времени – T ≤ t ≤ T:

– это множество сигналов, которые равны нулю за пределами интервала времени – T ≤ t ≤ T:

, то отношениеэквивалентности

, то отношениеэквивалентности

от центра зазора МГ, причём х = VН∙t.

от центра зазора МГ, причём х = VН∙t.

– безразмерный множитель. Полныё поток Фг(

– безразмерный множитель. Полныё поток Фг(

в выражение для ЭДС, получим:

в выражение для ЭДС, получим:

.

.

и

и  обозначают некоторые величины, заключённые в интервалах

обозначают некоторые величины, заключённые в интервалах

y+d.

y+d.

, причём сигнал оказывается максимальным при

, причём сигнал оказывается максимальным при