Заглавная страница Избранные статьи Случайная статья Познавательные статьи Новые добавления Обратная связь FAQ Написать работу КАТЕГОРИИ: ТОП 10 на сайте Приготовление дезинфицирующих растворов различной концентрацииТехника нижней прямой подачи мяча. Франко-прусская война (причины и последствия) Организация работы процедурного кабинета Смысловое и механическое запоминание, их место и роль в усвоении знаний Коммуникативные барьеры и пути их преодоления Обработка изделий медицинского назначения многократного применения Образцы текста публицистического стиля Четыре типа изменения баланса Задачи с ответами для Всероссийской олимпиады по праву

Мы поможем в написании ваших работ! ЗНАЕТЕ ЛИ ВЫ?

Влияние общества на человека

Приготовление дезинфицирующих растворов различной концентрации Практические работы по географии для 6 класса Организация работы процедурного кабинета Изменения в неживой природе осенью Уборка процедурного кабинета Сольфеджио. Все правила по сольфеджио Балочные системы. Определение реакций опор и моментов защемления |

Совместное распределение частот количественных признаковСодержание книги

Поиск на нашем сайте

Одна из задач статистики состоит в том, чтобы по данным наблюдений за признаками определить, связаны ли они между собой (зависят ли друг от друга) или нет. При n=2 частоты распределения представляют в таблице сопряженности (корреляционной таблице): Таблица 7 Корреляционная таблица

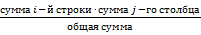

В этом случае существует только два маргинальных распределения частот — отдельно для 1-го признака (итоговый столбец таблицы сопряженности) и для 2-го признака (итоговая строка). Критерий Пирсона (Хи квадрат) Критерий Наблюдаемые значения — это те, которые мы получили из данных по выборке (пронаблюдали). Ожидаемые значения — это те, которые мы бы ожидали увидеть в том случае, если эти переменные независимы. Для расчета ожидаемых значений используется формула:

Далее производится расчет критерия

Необходимо: ü расчетное значение статистики ü если расчетное значение не превышает табличное (т.е. является достаточно малым), то нулевая гипотеза [ H 0: переменные независимы] не отвергается, и данные множества признаков считаются независимыми; ü если расчетное значение больше табличного, то множества признаков определяются как зависимые между собой с уровнем ошибки 5%. Регрессионный анализ Регрессионный анализ позволяет определить характер взаимосвязи между переменными

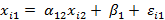

Причем На основе выборочного наблюдения оценивается (выборочное) уравнение регрессии. Оценки параметров регрессии и остатки обозначаются соответствующими буквами латинского алфавита. И уравнение парной регрессии, записанное по наблюдениям, будет иметь следующий вид:

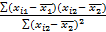

Основная задача регрессионного анализа состоит в наилучшей аппроксимации набора наблюдений ( Требуется подобрать параметры уравнения Метод наименьших квадратов (МНК) — метод нахождения оптимальных параметров линейной регрессии, таких, чтобы сумма квадратов ошибок (остатков) была минимальна. Выписываем сумму квадратов регрессионных остатков RSS (ResidualSumofSquares): RSS = Приравняв производные к нулю, получаем систему из двух уравнений. Откуда выражаем значения параметров:

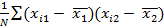

Матрица ковариаций переменных M = Коэффициент корреляции (Пирсона)

r≈ 0, случайные величины линейно независимы; r≈ 1, между случайными величинами существует прямая линейная зависимость; r≈ –1, между случайными величинами существует обратная линейная зависимость.

|

|||||||||||||||||||||||||||||||||||||||||||||||||||||

|

Последнее изменение этой страницы: 2021-05-12; просмотров: 136; Нарушение авторского права страницы; Мы поможем в написании вашей работы! infopedia.su Все материалы представленные на сайте исключительно с целью ознакомления читателями и не преследуют коммерческих целей или нарушение авторских прав. Обратная связь - 216.73.216.41 (0.006 с.) |

основан на разнице между наблюдаемыми и ожидаемыми значениями в каждой из ячеек корреляционной таблицы.

основан на разнице между наблюдаемыми и ожидаемыми значениями в каждой из ячеек корреляционной таблицы. =

=  .

. .

. сравнить со значением 95% квантиля

сравнить со значением 95% квантиля  - распределения (число степеней свободы df (degreesfree) = (

- распределения (число степеней свободы df (degreesfree) = ( , i =

, i =

— зависимая (объясняемая) переменная,

— зависимая (объясняемая) переменная, — независимая (объясняющая) переменная (фактор, регрессор),

— независимая (объясняющая) переменная (фактор, регрессор), — коэффициент регрессии (коэффициент наклона) — параметр уравнения,

— коэффициент регрессии (коэффициент наклона) — параметр уравнения, — свободный (постоянный) член — параметр уравнения,

— свободный (постоянный) член — параметр уравнения, — случайный член

— случайный член , i =

, i =  ), i=

), i=  и

и  , для чего используется Метод наименьших квадратов (МНК).

, для чего используется Метод наименьших квадратов (МНК). =

=  →

→  .

. –

–  ,

, =

=  =

=  , где

, где — дисперсия

— дисперсия  — мера разброса (вариации) случайной величины.

— мера разброса (вариации) случайной величины. =

=  =

=  ,

, – ковариация (cov) между

– ковариация (cov) между  и

и  =

=

имеет вид:

имеет вид: .

. =

=  ,

,  1

1