Заглавная страница Избранные статьи Случайная статья Познавательные статьи Новые добавления Обратная связь FAQ Написать работу КАТЕГОРИИ: ТОП 10 на сайте Приготовление дезинфицирующих растворов различной концентрацииТехника нижней прямой подачи мяча. Франко-прусская война (причины и последствия) Организация работы процедурного кабинета Смысловое и механическое запоминание, их место и роль в усвоении знаний Коммуникативные барьеры и пути их преодоления Обработка изделий медицинского назначения многократного применения Образцы текста публицистического стиля Четыре типа изменения баланса Задачи с ответами для Всероссийской олимпиады по праву

Мы поможем в написании ваших работ! ЗНАЕТЕ ЛИ ВЫ?

Влияние общества на человека

Приготовление дезинфицирующих растворов различной концентрации Практические работы по географии для 6 класса Организация работы процедурного кабинета Изменения в неживой природе осенью Уборка процедурного кабинета Сольфеджио. Все правила по сольфеджио Балочные системы. Определение реакций опор и моментов защемления |

Относительные частоты в описании случайных процессовСодержание книги

Поиск на нашем сайте

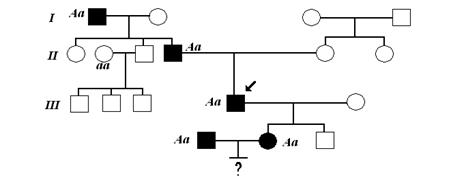

Относительные частоты в описании случайных процессов Для простоты рассмотрим генератор бинарного цифрового сигнала, выход которого случайно переключается между положениями 1 и -1 с 𝑇0-секундными интервалами, как показано на рисунке 7.1. Пусть 𝑋 (𝑡, ζ𝑖) случайный сигнал, соответствующий выходу генератора 𝑖th. Пусть относительная частота используется для оценки 𝑃 (𝑋 = +1) посредствам анализа результатов всех генераторов на определенный момент времени. Так как выходы являются функциями времени, мы должны указать время, когда записывается относительная частота. Следующая таблица может быть построена из данных генератора полученных на выходах в каждой промежуток времени. Показано на рисунке: Таблица Из этой таблицы видно, что относительные частоты изменяются с интервалом времени. Рисунок 7.1 Хотя это изменение относительной частоты может быть результатом статистической неоднородности высока вероятность того, что некоторые явления 𝑋 = 1 становятся более вероятны, с увеличением времени. Чтобы уменьшить вероятность того, что статистическая неравномерность является виновником отклонений мы могли бы повторить эксперимент с 100 или 1000 генераторов. Это, очевидно, мысленный эксперимент, потому что было бы очень трудно получить набор идентичных генераторов и подготовить их в идентичных модах. Некоторая терминология случайных процессов Примеры Функций и ансамблей Таким же образом, как это показано на рисунке 7.1, мы могли бы себе представить, использование любой возможности экспериментировать много раз одновременно. Если, например, случайная величина представлена как напряжение на клеммах генератора шума, случайная величина 𝑋1 может быть назначена для представления всевозможных значений этого напряжения в момент времени 𝑡1 и случайная величина 𝑋2 для значений в момент времени 𝑡2. Как и в случае с генератором цифрового сигнала, можно представить себе много генераторов шума построеных идентичным образом, поскольку мы можем сделать их, и считать, что они работают при идентичных условиях. На рисунке 7.2 (а) показаны типичные формы сигналов, генерируемых в таких экспериментах. Каждый сигнал 𝑋(𝑡, ζ𝑖) называется примером функции, где ζ𝑖 является членом из выборочного пространства S. Совокупность всех образцов функций называется ансамблем. Лежащий в основе эксперимент, приводящий к ансамблю выборочных функций, называется случайным или стохастическим процессом. Таким образом, для каждого результата ζ мы назначаем, в соответствии с определенным правилом, временную функцию 𝑋 (𝑡, ζ). Для конкретного ζ, скажем ζ𝑖, 𝑋 (𝑡, ζ𝑖) означает одну функцию времени. Для конкретных значений времени 𝑡𝑗, 𝑋 (𝑡𝑗, ζ) обозначает случайную величину. При фиксированном 𝑡 = 𝑡𝑗 и фиксированной ζ = ζ𝑖, 𝑋 (𝑡𝑗, ζ𝑖) является числом. В дальнейшем мы будем часто игнорировать ζ.

Подводя итог, различие между случайной величиной и случайным процессом является то, что длят случайной величины, исход в выборочном пространстве отображается в численном значении, а для случайного процесса отображается в функции зависимой от времени. Рисунок 7.2 Описание случайных процессов при условии совместимости с форматом PDF Полное описание случайного процесса {𝑋 (𝑡, ζ)} задается 𝑁-кратным совместной PDF, что вероятностно описывает возможные значения, принимаемые типичной функции образца при раз 𝑡𝑁> 𝑡𝑁-1> ⋯> 𝑡1, где 𝑁 является произвольным. Для 𝑁 = 1, мы можем интерпретировать эту совместную PDF 𝑓𝑋1 (𝑥1, 𝑡1), как 𝑓𝑋1 (𝑥1, 𝑡1) 𝑑𝑥1 = 𝑃 (𝑥1 - 𝑑𝑥1 <𝑋1 ≤ 𝑥1 в момент времени 𝑡1) (7.1) где 𝑋1 = 𝑋 (𝑡1, ζ). Аналогично, для 𝑁 = 2, мы можем интерпретировать совместная плотность 𝑓𝑋1𝑋2 (𝑥1, 𝑡1; 𝑥2, 𝑡2) как 𝑓𝑋1𝑋2 (𝑥1, 𝑡1; 𝑥2, 𝑡2) 𝑑𝑥1𝑑𝑥2 = 𝑃 (𝑥1 - 𝑑𝑥1 <𝑋1 ≤ 𝑥1 в момент времени 𝑡1 и 𝑥2 - 𝑑𝑥2 <𝑋2 ≤ 𝑥2 в момент времени 𝑡2) (7.2) где 𝑋2 = 𝑋 (𝑡2, ζ). Чтобы помочь в интерпретации (7.2), на рисунке 7.2 (б) показаны три выборочных функций, на рис 7.2 (а) накладываются барьеры, расположенные на 𝑡 = 𝑡1 и 𝑡 = 𝑡2. Согласно интерпретации относительной частоты, совместная вероятность числа образцов функции, которые проходят через прорези обоих барьеров, деленное на общее число 𝑀 образца действует как 𝑀 становится неограниченно большим и дается формулой (7.2).

Стационарность Мы указали на возможную зависимость 𝑓𝑋1𝑋2 от 𝑡1 и 𝑡2, путем включения их в свой аргумент. Если {𝑋 (𝑡)}, например, это гауссовский случайный процесс, то его значение в момент времени 𝑡1 и 𝑡2 будет описываться (6,187), где 𝑚𝑋, 𝑚𝑌, σ2𝑋, σ2𝑌 и ρ, в общем, зависят от 𝑡1 и 𝑡2. Обратите внимание, что мы нуждаемся в общей 𝑁 раза PDF(н мерной функцией) для полного описания случайного процесса {𝑋 (𝑡)}. В общем, такая PDF зависит от 𝑁 мгновений времени 𝑡1, 𝑡2,..., 𝑡𝑁. В некоторых случаях, эта совместная PDF зависит лишь от временных разниц 𝑡2 - 𝑡1, 𝑡3 - 𝑡1,..., 𝑡𝑁 - 𝑡1; то есть, выбор времени происхождения для случайного процесса не имеет значения. Такие случайные процессы, как говорят, статистически стационарный в строгом смысле слова, или просто стационарны. Для стационарных процессов, средние значения и дисперсии не зависят от времени, а корреляция коэффициента (или ковариация) зависит только от разности времени 𝑡2 - 𝑡1. Рисунок 7.3 контрастами выделены выборочные функции стационарных и нестационарных процессов. Может случиться, что в некоторых случаях среднее значение и дисперсия случайного процесса не зависят от времени, а ковариация зависит только от разницы во времени, но 𝑁 мерная совместная плотность зависит от времени происхождения. Такие случайные процессы называются стационарными в широком смысле процессов, чтобы отличать их от строго стационарные процессов (то есть, процессы, 𝑁 раза PDF не зависит от времени происхождения). Строгая стационарность подразумевает стационарность в широком смысле, но обратное не всегда верно. Исключение возникает для гауссовских случайных процессов, для которых в широком смысле стационарность подразумевает стационарность в строгом смысле, так как совместное гаусова PDF полностью задается Средствами, дисперсиями и ковариациями 𝑋 (𝑡1), 𝑋 (𝑡2),..., 𝑋 (𝑡𝑁). Рисунок 7.3 7.2.4 Частичное описания случайных процессов: Эргодичность Как и в случае случайных величин, мы не всегда требуем полного статистического описания случайного процесса, или мы, возможно, не можем получить 𝑁 мерную совместная плотность даже при желании. В таких случаях, мы работаем с различными моментами по выбору, либо по необходимости. Наиболее важные средние значения, (7.3) дисперсия, (7.4) и ковариация, (7.5) Введем в (7.5) обозначения t= 𝑡1 и 𝑡 + τ = 𝑡2. Первое слагаемое в правой части является автокорреляционной функцией, вычисляется как статистическая или ансамбль, в среднем (то есть, в среднем составляется по выборочным функциям в моменты 𝑡 и 𝑡 + τ). С точки зрения совместная плотность случайного процесса, автокорреляционная функция (7.6) где 𝑋1 = 𝑋 (𝑡1) и 𝑋2 = 𝑋 (𝑡2). Если процесс стационарный в широком смысле, 𝑓𝑋1𝑋2 не зависит от 𝑡, а разница во времени обозначена: τ = 𝑡2 - 𝑡1 и, как следствие, 𝑅𝑋 (𝑡1, 𝑡2) = 𝑅𝑋 (τ) является функцией только τ. Очень важным является вопрос: '' Если автокорреляционная функция использования определена средним временем, как указано в главе 2, будет ли результат такой же, как дает формула среднестатистического (7.6)? '' для многих процессов, называемых эргодическими, ответ утвердительный. Эргодические процессы – это процессы, для которых время и ансамбль среднего значения взаимозаменяемы. Таким образом, если 𝑋 (𝑡) эргодический процесс, все время и соответствующий ансамбль среднего являются взаимозаменяемыми. В частности,

(7.7) (7.8) и (7.9) где (7.10) как это определено в главе 2. Мы подчеркиваем, что для эргодических процессов все время и ансамбль среднего являются взаимозаменяемыми, а не только среднее значение, дисперсия и Автокорреляционная функция. Пример 7.1 Рассмотрим случайный процесс у выборочных функций 𝑛(𝑡) = 𝐴 cos(2𝜋𝑓0𝑡 + Θ) где 𝑓0 является постоянным, Θ является случайной величиной с PDF (7.11) Вычисляется как статистических средние, первый и второй моменты (7.12) И (7.13) соответственно. Дисперсия равна второму моменту, так как длина равна нулю. Вычисляется как средние время, первый и второй моменты (7.14) И (7.15) соответственно. В общем, время в среднем некоторой функции ансамбля член случайного процесса является случайной величиной. В этом примере, ⟨𝑛 (𝑡)⟩ и ⟨𝑛2 (𝑡)⟩ Постоянны! Мы подозреваем, что этот случайный процесс является стационарным и эргодическим, хотя предыдущие результаты не доказывают это. Оказывается, что это действительно так. Продолжая пример, рассмотрим PDF (7.16) В этом случае, ожидаемое значение, или среднее, случайного процесса вычисляется в произвольный момент времени 𝑡. (7.17) Второй момент, вычисляется как статистическое среднее, это (7.18) Поскольку из стационарности случайного процесса следует, что все моменты не зависят от начала отсчета времени, результаты показывают, что этот процесс не является стационарным. Для того, чтобы понять физическую причину этого, вы должны нарисовать некоторые типичные функции образца. Кроме того, этот процесс не может быть эргодическим, поскольку эргодичность требует стационарности. Действительно, среднее по времени первый и второй моменты по-прежнему ⟨𝑛 (𝑡)⟩ = 0 и ⟨𝑛2 (𝑡)⟩ = 1, соответственно. Таким образом, мы обнаружили два временных средних, которые не равны соответствующим статистическим средним. Рисунок 7.4 Пример функции случайного телеграфного сигнала. (7.19) Предыдущее выражение было проведено в предположении, что τ был положительным. Это может переписать аналогичным образом с τ отрицательным, так что:

(7.20) Это результат, который имеет место для всех τ. То есть, 𝑅𝑋 (τ) является четной функцией τ, которую в общем мы покажем в ближайшем изложении. Пример 7.3 Найдем спектральную плотность мощности случайного процесса, рассмотренную в примере 7.1, используя (7.25). В этом случае, (7.26) По теореме о времени задержки преобразований Фурье и с использованием пары преобразований (7.27) мы получаем (7.28) Вспомним также, из главы 2 (пример 2.8), что Π (𝑡 / 𝑇) ⟷ 𝑇 sinc𝑇 𝑓, поэтому используем теорему преобразований Фурье, (7.29) Таким образом, энергия спектральной плотности усреднённой функции образца является (7.30) При получении [|| 𝑁𝑇 (𝑓, Θ) ||2]. Отметим, что (7.31) Таким образом, мы получаем (7.32) и спектральная плотность мощности является (7.33) Тем не менее, представлением дельта-функции является lim𝑇 → ∞ 𝑇 sinc2 𝑇 𝑢 = δ (𝑢). [См рисунок 2.4 (б).] Таким образом, (7.34) Средняя мощность ∫ ∞ -∞ 𝑆𝑛 (𝑓) 𝑑𝑓 = ½ 𝐴2, такая же, как полученная в примере 7.1 Теорема Винера - Хинчина Теорема Винера - Хинчина утверждает, что спектральной плотностью мощности стационарного в широком смысле случайного процесса является преобразование Фурье соответствующей автокорреляционной функции. Целью данного подраздела, является обеспечение формального доказательства этого утверждения. Для упрощения обозначений в доказательстве теоремы Винера - Хинчина, перепишем (7,25) как (7.35) где для удобства мы отбрасываем вторые интервала 2𝑇 и опустим ζ в аргумент 𝑛2𝑇 (𝑡). Обратите внимание, что (7.36) произведение двух интегралов было записано в качестве повторного интеграла. Взяв ансамбль среднего и поменяв местами усреднение и интегрирование, получаем (7.37) Figure 7.5 согласно определению автокорреляционной функции. Произведем замену переменных 𝑢 = 𝑡 - σ и 𝑣 = 𝑡, теперь обратимся к рис 7,5. В 𝑢𝑣 плоскости мы интегрируем по 𝑣, а затем по 𝑢, разбивая интегрирование по 𝑢 на две интеграла, один для отрицательного 𝑢 и один для положительного 𝑢. таким образом, (7.38) Спектральная плотность мощности в силу (7.35), (7.39) которая является пределом 𝑇 → ∞ результат (7.21). Пример 7.4 Поскольку спектральная плотность мощности и автокорреляционная функция Фурье-преобразование пары, автокорреляция функции случайного процесса, определена в примере 7.1, а из результата примера 7.3, дается (7.40) Вычисляя 𝑅𝑛 (τ), при усреднении по ансамблю, мы получим (7.41) что то же самое, что и результат, полученный с помощью теоремы Винера – Хинчина. Пример 7.5 Процессы, для которых (7.47) где 𝑁0 является константой, которую обычно называют белым шумом ограниченной полосы частот, так как 𝐵 → ∞, имеются все частоты, и в этом случае процесс просто называют белым. 𝑁0 является односторонней мощностью спектральной плотности, не ограниченной полосы частот процесса. Для ограниченной полосой частот процесса белого шума,

(7.48) Поскольку 𝐵 → ∞, 𝑅 (τ) → 1/2 𝑁0δ (τ). То есть, независимо от того, насколько близко мы производим выборку белого шума, на образцах имеется нулевая корреляция. Кроме того, если, процесс является Гауссовым, образцы независимы. Процесс белого шума имеет бесконечную мощность и, следовательно, математическую идеализацию, но тем не менее, полезен в анализе систем. Пример 7.6 В данном примере рассмотрим случай, когда последовательность { ak } построена следующем соотношением: (7.56) Где g0 и g1 постоянные и Ak, Ak-1 случайные величины, такие что Ak=±A, где знак определяется случайным образом независимо от импульса к импульсу для все k (отметим, что если g1=0, то предыдущего значения нет). Это можно представить следующим образом: (7.57) Предполагаемая форма импульса p(t)=Π(t/T), таким образом импульсно-корреляционная функция: (7.58) Где, из главы 2, Λ(t/T) единица высоты треугольного импульса симметричного относительно t=0 и шириной 2T. Таким образом, автокорреляционная функция становится: (7,59) Применяя теорему Винера-Хинчина, спектральная плотность мощности X(t) оказывается: (7.60)

(Картинки) Рисунок 7.6. Спектр мощности бинарного сигнала. (а) – случай при отсутствии памяти (предыдущего значения). (b) – случай, в котором есть усиление связи между соседними импульсами. (c) – случай, когда связь между соседними импульсами диаметрально противоположна.

На рисунке 7.6 сравнивается спектр мощности для 2-х случаев: (1) g0=1 и g1=0; (2) g0= g1=1/√2 (усиление связи между соседними импульсами). Для первого случая в результате спектральная плотность мощность следующая: (7.61) Для второго: (7.62) В обоих случаях, g0 и g1 были выбраны таким образом, чтобы получить полную мощность 1Вт, что проверяется из графиков с помощью численного интегрирования. Отметим, что во втором случае наличие связи ограничило спектр мощности больше, чем без нее. Тем не менее, третий случай, показанный на нижнем графике, для которого g0= -g1=1/√2. Здесь ширина спектра больше чем во втором случае в 2 раза, но спектральный нуль появляется в f=0. Можно предположить другие значения g0 и g1 и связь между не соседними импульсами.

Относительные частоты в описании случайных процессов Для простоты рассмотрим генератор бинарного цифрового сигнала, выход которого случайно переключается между положениями 1 и -1 с 𝑇0-секундными интервалами, как показано на рисунке 7.1. Пусть 𝑋 (𝑡, ζ𝑖) случайный сигнал, соответствующий выходу генератора 𝑖th. Пусть относительная частота используется для оценки 𝑃 (𝑋 = +1) посредствам анализа результатов всех генераторов на определенный момент времени. Так как выходы являются функциями времени, мы должны указать время, когда записывается относительная частота. Следующая таблица может быть построена из данных генератора полученных на выходах в каждой промежуток времени. Показано на рисунке: Таблица Из этой таблицы видно, что относительные частоты изменяются с интервалом времени. Рисунок 7.1 Хотя это изменение относительной частоты может быть результатом статистической неоднородности высока вероятность того, что некоторые явления 𝑋 = 1 становятся более вероятны, с увеличением времени. Чтобы уменьшить вероятность того, что статистическая неравномерность является виновником отклонений мы могли бы повторить эксперимент с 100 или 1000 генераторов. Это, очевидно, мысленный эксперимент, потому что было бы очень трудно получить набор идентичных генераторов и подготовить их в идентичных модах.

|

|||||||||

|

Последнее изменение этой страницы: 2016-04-21; просмотров: 245; Нарушение авторского права страницы; Мы поможем в написании вашей работы! infopedia.su Все материалы представленные на сайте исключительно с целью ознакомления читателями и не преследуют коммерческих целей или нарушение авторских прав. Обратная связь - 18.116.24.238 (0.012 с.) |