Заглавная страница Избранные статьи Случайная статья Познавательные статьи Новые добавления Обратная связь КАТЕГОРИИ: ТОП 10 на сайте Приготовление дезинфицирующих растворов различной концентрацииТехника нижней прямой подачи мяча. Франко-прусская война (причины и последствия) Организация работы процедурного кабинета Смысловое и механическое запоминание, их место и роль в усвоении знаний Коммуникативные барьеры и пути их преодоления Обработка изделий медицинского назначения многократного применения Образцы текста публицистического стиля Четыре типа изменения баланса Задачи с ответами для Всероссийской олимпиады по праву

Мы поможем в написании ваших работ! ЗНАЕТЕ ЛИ ВЫ?

Влияние общества на человека

Приготовление дезинфицирующих растворов различной концентрации Практические работы по географии для 6 класса Организация работы процедурного кабинета Изменения в неживой природе осенью Уборка процедурного кабинета Сольфеджио. Все правила по сольфеджио Балочные системы. Определение реакций опор и моментов защемления |

Количество информации в системе равновероятных событий. Подход Хартли.

Получение любой информации неразрывно связано с проведением опыта в той или иной форме. Под опытом понимается процесс, в результате которого наблюдатель (человек или автоматическое устройство) получает новые сведения (информацию) о некотором интересующем объекте. В частности, опытами являются чтение или прослушивание незнакомого текста, регистрация на ПЗС-матрицу изображений, измерения длины, яркости, интенсивности и т.п. Иначе говоря, под опытом понимается любой процесс получения и обработки одного или нескольких сигналов. При этом априори (до опыта) однозначно не известно, какие сигналы и в какой последовательности будут воздействовать на приемник информации (глаза человека, ПЗС-матрица и т.д.), т.е. результат опыта до его проведения является в той или иной степени неопределенным. Апостериори (после опыта) эта неопределенность частично или полностью устраняется. Интуитивно ясно, что за меру количества информации, получаемой в результате опыта, можно принять величину, характеризующую меру уменьшения неопределенности сведений о наблюдаемом объекте. Для введения последней необходимо привлечение понятий теории вероятностей, поскольку наши звания о наблюдаемом объекте до проведения опыта носят характер предсказаний и являются вероятностными оценками. Первую попытку количественного определения информации предпринял в 1928 году американский инженер Р. Хартли. С целью сравнения и оптимизации параметров линий связи он рассмотрел возможность введения количественной меры информации, содержащейся в некотором сообщении. Следуя Хартли, предположим, что для записи и передачи сообщений используется язык, характеризующийся алфавитом символов: L 1, L 2, … LS S – число символов (букв) (например 0, 1). Пусть передатчик генерирует слова, состоящие из n букв (например, 01001011, 8 букв) в количестве N. При отсутствии ограничений на возможные повторения и порядок следования букв в слове, количество N различных слов, длиной n букв, согласно теории вероятности, равно: N = Sn (28). Поскольку при приеме сообщения известна длина слова n, то неопределенность опыта по точной регистрации очередного слова характеризуется величиной N – количеством равновероятных исходов опыта, т.о. чем больше N – тем больше информации мы получаем в результате проведения опыта. Вывод: мера измерения количества информации должна быть неубывающей функцией от N.

Для выбора наиболее удобного с практической точки зрения вида этой функции учтем два обстоятельства: а) мера информации должна быть пропорциональна длине слова n, т.е. I = n ∙ K, где I - количество информации, K - коэффициент пропорциональности; б) мера должна позволять сравнивать информационные возможности разных систем (с различными n и S), т.е. необходимо выразить величину К через S. Рассмотрим две системы, характеризующиеся параметрами n 1, S 1, N1, I 1 и n 2, S 2, N2, I 2, обладающие одинаковыми информационными возможностями I 1 = I 2. Тогда можно записать n 1 K 1 = n 2 K 2 (1) и K 1 / K 2 = n 2 / n 1 . (2) Поскольку из условия равенства количеств информации, получаемых при приеме одного слова в обеих системах, должно следовать равенство N1 = N2, (3) имеем S1n1 = S2n2 или n1 lg S1 = n2 lg S2 (4) Подставив (4) в (2), получим K 1 / K 2 = lg S 1 / lg S 2 (5) Таким образом, коэффициент K пропорционален логарифму числа символов алфавита. Следовательно, выражение для меры количества информации по Хартли можно записать в виде: I = n lg S = lg Sn = lg N. (6) Например, если у нас имеется устройство, формирующее сообщения из состоящие из двух символов S = 2 и длиной из 8 букв n = 8, то такое устройство может передать количество информации I = lg 28= lg 256. Можно заметить, что, lg N = - lg p, где р = 1/ N - вероятности регистрации какого-либо слова, которые по условиям опыта одинаковы. Итак, по Хартли количество информации, получаемое в результате опыта, равно логарифму числа возможных равновероятных исходов.

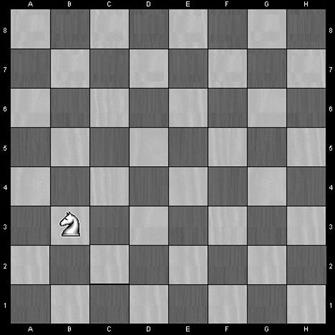

Логарифмическая мера Хартли обладает свойством аддитивности, т.е. позволяет суммировать количества информации независимых систем при определении общего количества информации, получаемого в обеих системах совместно. Действительно, пусть проводятся два опыта по регистрации слов независимыми системами связи; при этом число независимых исходов в 1-ой системе равно N1, а во второй – N2. Общее количество возможных исходов Nсум в опыте по регистрации одного слова первой системой и одного слова второй равно Nсум= N1 ∙N2 (7) Следовательно, общее количество информации I сум = lgN сум = lgN 1 + lgN 2 = I 1 + I 2, (8) где I 1 и I 2 - количества информации, получаемые в первой и второй системах соответственно. В зависимости от основания логарифмов, используемого в выражениях (6),(8) находят применение следующие единицы измерения количества информации: а) бит - двоичная единица (англ. bit — binary digit — двоичная цифра), при использовании которой I = log 2 N; б) дит - десятичная единица, при использовании которой I = lgN; в) нат - натуральная единица, при использовании которой I = lnN. Выбор той или иной единицы измерения обуславливается удобством вычислений. Нат применяется в различных математических выкладках, которые упрощаются при использовании натуральных логарифмов. Дит используется при анализе измерительных устройств, работающих в десятичной или двоично-десятичной системах счисления. Бит наиболее употребительная единица, информация размером в один бит содержится в ответе на вопрос, требующий ответа “да” или “нет”. Бит применяется при анализе различных компьютерных устройств, а в вычислительной технике битом называют наименьшую "порцию" памяти, необходимую для хранения одного из двух знаков "0" и "1", используемых для внутримашинного представления данных и команд. Поскольку бит является наиболее распространенной единицей измерения, ниже все рассуждения будут проводиться с использованием этой единицы. Рассмотрим примеры, поясняющие меру Хартли и единицу измерения информации - бит. Допустим, что наш текст передается с помощью азбуки Морзе, когда каждой букве сопоставляется некоторый набор точек и тире. Более того, рассмотрим упрощенный случай, когда текст идет подряд без всяких промежутков между буквами и словами. Тогда мы увидим одну сплошную ленту только из точек и тире. В каждой позиции может быть только один из двух символов: либо точка, либо тире. Когда имеется только один из двух вариантов символов, то каждая из ячеек имеет один бит информации. Вся лента Морзе, имеющая N символов, содержит N бит информации. Можно сказать, что такая лента "запомнила" определенный текст, и в каждой из ее N "ячеек памяти" заложен один бит информации. Пример 1. На одном из полей шахматной доски установлена фигура (рис.40). Найдите количество информации, содержащееся в каждом из сообщений: а) конь находится не вертикали B; б) конь находится на горизонтали 3; в) конь находится на поле В3.

Рис. 40. Пояснение к примеру 1

Заметим, что рассматриваемый пример идентичен случаю нахождения изображения точечного объекта наблюдения на одном из пикселей ПЗС-матрицы размером 8x8.

Решение. а) Шахматная доска имеет 8 вертикалей (для рассматриваемого случая это эквивалентно 8 словам или ситуациям), поэтому NB = 8 и IB = log28 = 3 бит; б) Шахматная доска имеет 8 горизонталей, поэтому N Г = 8; I Г = log28 = 3 бит; в) Шахматная доска имеет 64 поля, поэтому N П = 64; I П = log264 = 6 бит. С другой стороны N П = NB ∙ N Г и I П = log2 (NB ∙ N Г)= log2 NB + log2 N Г = 6 бит. Отсюда видно, что мера Хартли действительно обладает свойством аддитивности, позволяющим находить количество информации, содержащееся в полном сообщения, путем суммирования количеств информации, содержащихся в его независимых составных частях. Поясним логический смысл количества информации на рассмотренном примере. Пусть для выяснения местоположения коня задаются вопросы и отвечающий может воспользоваться только двумя ответами «Да» или «Нет». Тогда количество информации в битах, численно равно количеству правильно заданных вопросов, необходимых для выяснения ситуации, содержащейся в сообщении. Это означает, например, что 6 бит информации, содержащихся в сообщении «конь находится на поле B3», соответствуют 6 заданным вопросам, необходимым для выяснения местоположения фигуры.

|

|||||||

|

Последнее изменение этой страницы: 2021-03-10; просмотров: 86; Нарушение авторского права страницы; Мы поможем в написании вашей работы! infopedia.su Все материалы представленные на сайте исключительно с целью ознакомления читателями и не преследуют коммерческих целей или нарушение авторских прав. Обратная связь - 18.224.149.242 (0.011 с.) |