Заглавная страница Избранные статьи Случайная статья Познавательные статьи Новые добавления Обратная связь КАТЕГОРИИ: ТОП 10 на сайте Приготовление дезинфицирующих растворов различной концентрацииТехника нижней прямой подачи мяча. Франко-прусская война (причины и последствия) Организация работы процедурного кабинета Смысловое и механическое запоминание, их место и роль в усвоении знаний Коммуникативные барьеры и пути их преодоления Обработка изделий медицинского назначения многократного применения Образцы текста публицистического стиля Четыре типа изменения баланса Задачи с ответами для Всероссийской олимпиады по праву

Мы поможем в написании ваших работ! ЗНАЕТЕ ЛИ ВЫ?

Влияние общества на человека

Приготовление дезинфицирующих растворов различной концентрации Практические работы по географии для 6 класса Организация работы процедурного кабинета Изменения в неживой природе осенью Уборка процедурного кабинета Сольфеджио. Все правила по сольфеджио Балочные системы. Определение реакций опор и моментов защемления |

Независимые факторы: спецификация модели

В этом пункте используется модель линейной регрессии в сокращенной фор- ме, поэтому переменные берутся в центрированной форме, а m и M — вектор и матрица соответствующих коэффициентов ковариации переменных. Под спецификацией модели в данном случае понимается процесс и результат определения набора независимых факторов. При построении эконометрической модели этот набор должен обосновываться экономической теорией. Но это удается не во всех случаях. Во-первых, не все факторы, важные с теоретической точки зрения, удается количественно выразить. Во-вторых, эмпирический анализ часто предшествует попыткам построения теоретической модели, и этот набор просто неизвестен. Потому важную роль играют и методы формального отбора факторов, также рассматриваемые в этом пункте. В соответствии с гипотезой g 2 факторные переменные не должны быть ли- нейно зависимыми. Иначе матрица M в операторе МНК-оценивания будет необ- ратима. Тогда оценки МНК по формуле a = M −1 m невозможно будет рассчитать, но их можно найти, решая систему нормальных уравнений (6.14): Ma = m. Решений такой системы нормальных уравнений (в случае необратимости матри- цы M) будет бесконечно много. Следовательно, оценки нельзя найти однозначно, т.е. уравнение регрессии невозможно идентифицировать. Действительно, пусть оценено уравнение

где x ˆ = z ˆ1 a 1 + e, (7.51) z ˆ1 — вектор-строка факторных переменных размерности n 1, a 1 — вектор- столбец соответствующих коэффициентов регрессии, и пусть в это уравнение вво- дится дополнительный фактор z ˆ2, линейно зависимый от z ˆ1, т.е. z ˆ2 = z ˆ1 c 21. Тогда оценка нового уравнения

(«звездочкой» помечены новые оценки «старых» величин) эквивалентна оценке уравнения x ˆ = z ˆ1 (a ∗ + a 2 c 21)+ e ∗. Очевидно, что a 1 = a ∗ + a 2 c 21, e = e ∗, и, про- 1 1

Логичнее всего положить a 2 = 0, т.е. не вводить фактор z ˆ2. Хотя, если из со-

держательных соображений этот фактор следует все-таки ввести, то тогда надо исключить из уравнения какой-либо ранее введенный фактор, входящий в z ˆ1. Та- ким образом, вводить в модель факторы, линейно зависимые от уже введенных, бессмысленно.

7.3. Независимые факторы: спецификация модели 235

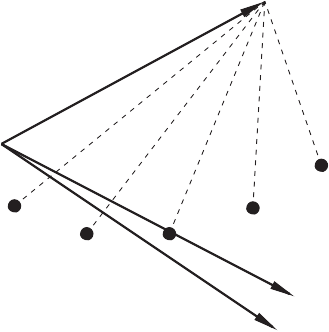

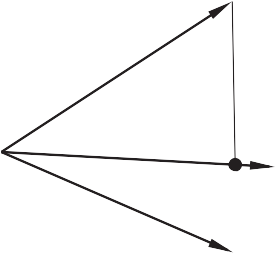

Случаи, когда на факторных переменных су- ществуют точные линейные зависимости, встре- чаются редко. Гораздо более распространена си- туация, в которой зависимости между фактор- ными переменными приближаются к линейным. Такая ситуация называется мультиколлинеарно- O стью. Она чревата высокими ошибками получа- емых оценок и высокой чувствительностью ре- зультатов оценивания к ошибкам в факторных переменных, которые, несмотря на гипотезу g 2, обычно присутствуют в эмпирическом анализе. Действительно, в такой ситуации матрица M плохо обусловлена и диагональные элементы

C

B

Рис. 7.1 M −1, определяющие дисперсии оценок, могут принимать очень большие значения. Кроме того, даже небольшие изменения в M, связанные с ошибками в факторных переменных, могут повлечь существенные изменения в M −1 и, как следствие, — в оценках a. Последнее наглядно иллюстрируется рисунком (рис. 7.1) в пространстве наблюдений при n = 2. На этом рисунке: O A — x ˆ, O B — z ˆ1, O C — z ˆ2. Видно, что факторные переменные сильно коррелированы (угол между соответству- ющими векторами мал). Поэтому даже небольшие колебания этих векторов, связанные с ошибками, зна- чительно меняют положение плоскости, которую они определяют, и, соответствен- но, — нормали на эту плоскость. Из рисунка видно, что оценки параметров регрессии «с легкостью» меняют не только свою величину, но и знак. По этим причинам стараются избегать ситуации мультиколлинеарности. Для этого в уравнение регрессии не включают факторы, сильно коррелирован- ные с другими. Можно попытаться определить такие факторы, анализируя матрицу коэффи- циентов корреляции факторных переменных S −1 MS −1, где S — диагональная матрица среднеквадратических отклонений. Если коэффициент s jj t этой матри- цы достаточно большой, например, выше 0. 75, то один из пары факторов j и j t не следует вводить в уравнение. Однако такого элементарного «парного» анализа может оказаться не достаточно. Надежнее построить все регрессии на множестве факторных переменных, последовательно оставляя в левой части уравнения эти переменные по отдельности. И не вводить в уравнение специфицируемой моде- ли (с x в левой части) те факторы, уравнения регрессии для которых достаточно значимы по F -критерию (например, значение pv не превышает 0. 05).

236 Глава 7. Основная модель линейной регрессии

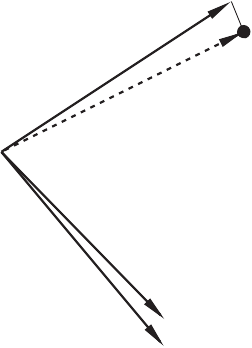

D коррелированных факторов может привести к по- строению значимой модели. O Это утверждение можно проиллюстрировать ри- сунком (рис. 7.2) в пространстве наблюдений при n = 2. На этом рисунке: O A — x ˆ, O B — z ˆ1, O C — C z ˆ2, A D — нормаль на плоскость, определяе- мую векторами OB и OC, OD — проекция B OA на эту плоскость.

Рис. 7.2 Из рисунка видно, что z ˆ1 и z ˆ2 по отдельности не объясняют x ˆ (углы между соответствующими векторами близки к 90◦), но вместе они определяют плоскость, угол между которой и вектором O A очень мал, т.е. коэффициент детерминации в регрессии x ˆ на z ˆ1, z ˆ2 близок к единице. Рисунок также показывает, что такая ситуация возможна только если факторы силь- но коррелированы.

В таких случаях особое внимание должно уделяться точности измерения фак- торов. Далее определяются последствия введения в уравнение дополнительного фак- тора. Для этого сравниваются оценки уравнений (7.51, 7.52) в предположении, что z ˆ2 линейно независим от z ˆ1. В этом анализе доказываются два утверждения. 1) Введение дополнительного фактора не может привести к сокращению ко- эффициента детерминации, в большинстве случаев он растет (растет объясненная дисперсия). Коэффициент детерминации остается неизменным тогда и только то- гда, когда вводимый фактор ортогонален остаткам в исходной регрессии (линейно независим от остатков), т.е. когда

t

(понятно, что коэффициент детерминации не меняется и в случае линейной зависи- мости z ˆ2 от z ˆ1, но такой случай исключен сделанным предположением о линейной независимости этих факторов; в дальнейшем это напоминание не делается).

Для доказательства этого факта проводятся следующие действия. Записываются системы нормальных уравнений для оценки регрессий (7.51, 7.52): m 1 = M 11 a 1 , (7.54)

7.3. Независимые факторы: спецификация модели 237 m M m a ∗ 1 = 11 12 1 m 2 m 21 m 22 , (7.55) a 2 1 1 1 1

где m 1 = Z ˆr X ˆ, m 2 = Z ˆr X ˆ, M 11 = Z ˆr Z ˆ, m

= m r = Z ˆr Z ˆ,

m 22 = N Z ˆr Z ˆ. 2 1 1 12 21 1 2

Далее, с помощью умножения обеих частей уравнения (7.51), расписанного по на- 1 блюдениям, слева на Z ˆr , устанавливается, что

m 2 − m 21 a 1 (7. 53) = m 2 e, (7.56)

= Z ˆ a 21 + e 21 , в которой по предположению e 21 ƒ= 0, находится

s 2 1 (7. 9) 1

= m 22 − m 21 − > 0 . (7.57) Из первой (верхней) части системы уравнений (7.55) определяется:

M 11 a ∗ + m 12 a 2 = m 1 (7. 54) = M 11 a 1, a ∗ −1 1 = a 1 − M 11 m 12 a 2 . (7.58) Из второй (нижней) части системы уравнений (7.55) определяется:

m 22 a 2 = m 2 − m 21 a ∗

− 11

и, учитывая (7.56, 7.57),

Наконец, определяется объясненная дисперсия после введения дополнительного фактора:

s 2∗ (7. 9) (7. 58) (7. 56) q = m r a ∗ + m 2 a 2 = m r a 1 + m 2 − m r M −1 m 12 a 2 = s 2 + m 2 e a 2, 1 1 1 1 11 q

q ←−−−r −→

(7.60)

238 Глава 7. Основная модель линейной регрессии

т.е.

s 2∗ (7. 59) 2 e

2 . e 21

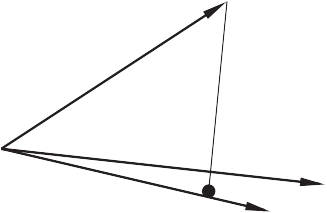

Что и требовалось доказать. Это утверждение легко проиллюстрировать рисунком 7.3 в пространстве наблюде- ний при n 1 = 1. На этом рисунке: O A — x ˆ, O B — z ˆ1, O C — z ˆ2, A D — нормаль x ˆ на (DA — вектор e). z ˆ1 Рисунок показывает, что если z ˆ2 ортогонален e, то нормаль x ˆ на плоскость, опре- деляемую z ˆ1 и z ˆ2, совпадает с A D, т.е. угол между этой плоскостью и x ˆ совпадает с углом между x ˆ и z ˆ1, введение в уравнение нового фактора z ˆ2 не меняет коэффи- циент детерминации. Понятно также и то, что во всех остальных случаях (когда z ˆ2 не ортогонален e) этот угол уменьшается и коэффициент детерминации растет.

После введения дополнительного фактора z ˆ2 в уравнение максимально коэффициент детерми- нации может увеличиться до единицы. Это про- изойдет, если z ˆ2 является линейной комбинацией x ˆ и z ˆ1.

Рост коэффициента детерминации с увеличе- O нием количества факторов — свойство коэффи- циента детерминации, существенно снижающее его содержательное (статистическое) значение. Введение дополнительных факторов, даже если они по существу не влияют на моделируемую пе- A

D B

Рис. 7.3 ременную, приводит к росту этого коэффициента. И, если таких факторов введено достаточно много, то он начнет приближаться к единице. Он обязательно достигнет единицы при n = N − 1. Более приемлем в роли критерия качества коэффициент детерминации, скорректированный на число степеней свободы: 1

N − n − 1 (1 − R 2 — отношение остаточной дисперсии к объясненной, которые имеют, со- ответственно, N − n − 1 и N − 1 степеней свободы), этот коэффициент может снизиться после введения дополнительного фактора. Однако наиболее правильно при оценке качества уравнения ориентироваться на показатель pv статистики F c.

Скорректированный коэффициент детерминации построен так, что он, так сказать, штрафует за то, что в модели используется слишком большой набор факторов. На этом же принципе построено и большинство других критериев, используемых

7.3. Независимые факторы: спецификация модели 239

в литературе): Крит е рий Ма ллоу за:

2( n 1 + 1) N

ров. Инфор м а ц ионный крит е рий Акаик е:

2( n 1 + 1). N Бай е совский инфор м а ц ионный крит е рий (критерий Шварца): ln( N )( n 1 + 1)

N В тех же обозначениях скорректированный коэффициент детерминации имеет вид

s 2 N − 1, e (∅) N − n 1 − 1

Регрессия тем лучше, чем ниже показатель C p (A I C, B I C). Для R ˜2 используется противоположное правило — его следует максимизировать. Вместо R ˜2 при неиз- менном количестве наблюдений N можно использовать несмещенную остаточную дисперсию s ˆ2 = s ˆ2(z 1), которую уже следует минимизировать. e e В идеале выбор модели должен происходить при помощи полного перебора воз- можных регрессий. А именно, берутся все возможные подмножества факторов z 1, для каждого из них оценивается регрессия и вычисляется критерий, а затем выби-

рается набор z 1, дающий наилучшее значение используемого критерия.

Различие в жесткости проистекает из различия в целях. Критерии Cp и A I C на- правлены на достижение высокой точности прогноза: Cp направлен на миними- зацию дисперсии ошибки прогноза (о ней речь пойдет в следующем параграфе),

240 Глава 7. Основная модель линейной регрессии

а A I C — на минимизацию расхождения между плотностью распределения по ис- тинной модели и по выбранной модели. В основе B I C лежит цель максимизации вероятности выбора истинной модели.

2) Оценки коэффициентов регрессии при факторах, ранее введенных в уравне- ние, как правило, меняются после введения дополнительного фактора. Они оста- ются прежними в двух и только двух случаях: а) если неизменным остается ко- эффициент детерминации и выполняется условие (7.53) (в этом случае уравнение в целом остается прежним, т.к. a 2 = 0); б) если новый фактор ортогонален старым (z ˆ1 и z ˆ2 линейно не зависят друг от друга), т.е.

A

(в этом случае объясненная дисперсия равна сумме C дисперсий, объясненных факторами z ˆ1 и z ˆ2 по от- O F дельности).

отношения следует, что оценки a 1 не меняются, если a 2 = 0 (случай «а») или/и m 12 = 0 (случай «б»).

D E

B

Рис. 7.4 Случай «а», как это следует из (7.59), возникает, когда выполняется (7.53). В случае «б» соотношение (7.60) переписывается следующим образом: s 2∗ (7. 9) a ∗= a 1 r

= m a 1 + m 2 a 2, 1 1 1 т.к. вторая (нижняя) часть системы (7.55) означает в этом случае, что m 22 a 2 = m 2, т.е. a 2 — оценка параметра в регрессии x ˆ по z ˆ2: x ˆ = z ˆ2 a 2 + e 2 = s 2 + s 2 , (7.62)

q q 2

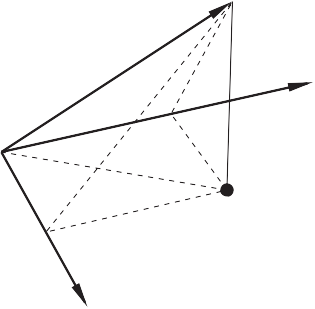

— дисперсия x ˆ, объясненная только z ˆ2. Что и требовалось доказать. Иллюстрация случая «а» при n 1 = 1 достаточно очевидна и дана выше. Рисунок 7.4 иллюстрирует случай «б». На этом рисунке: O A — x ˆ, O B — z ˆ1, O C — z ˆ2, E A — e, нормаль x ˆ на z ˆ1, F A — e 2, нормаль x ˆ на z ˆ2, D A — e ∗ , нормаль x ˆ на плоскость, определенную z ˆ1 и z ˆ2, E D — нормаль к z ˆ1, F D — нормаль к z ˆ2. Понятно (геометрически), что такая ситуация, когда точка E является одновре- менно началом нормалей EA и ED, а точка F — началом нормалей FA и FD, возможна только в случае, если угол COB равен 90◦.

7.3. Независимые факторы: спецификация модели 241

(OE + OF + DA = OA) и (7.62) (OF + FA = OA), т.е. что введение нового фактора не меняет оценку при «старом» факторе, а «новая» объясненная дисперсия равна сумме дисперсий, объясненных «старым» и «новым» факторами по отдельности (сумма квадратов длин векторов OE и OF равна квадрату длины вектора OD).

На основании сделанных утверждений можно сформулировать такое правило введения новых факторов в уравнение регрессии: вводить в ре- грессию следует такие факторы, которые имеют высокую корреляцию с остатками по уже введен- ным факторам и низкую корреляцию с этими уже O введенными факторами. В этом процессе следует пользоваться F -критерием: вводить новые фак- торы до тех пор, пока уменьшается показатель pv F -статистики. В таком процессе добавления новых факторов в регрессионную модель некоторые из ранее вве-

D C

B

Рис. 7.5 денных факторов могут перестать быть значимыми, и их следует выводить из урав- нения.

Эту возможность иллюстрирует рисунок 7.5 в пространстве наблюдений при n 1 = 1. На этом рисунке: O A — x ˆ, O B — кость, определенную z ˆ1 и z ˆ2. z ˆ1, O C — z ˆ2, A D — нормаль x ˆ на плос- Рисунок показывает, что нормаль AD «легла» на вектор вновь введенного фактора. Следовательно, «старый» фактор входит в «новую» регрессию с нулевым коэффи- циентом. Это — крайний случай, когда «старый» фактор автоматически выводится из уравне- ния. Чаще встречается ситуация, в которой коэффициенты при некоторых «старых» факторах оказываются слишком низкими и статистически незначимыми.

Процесс, в котором оценивается целесообразность введения новых факторов и выведения ранее введенных факторов, называется шаговой регрессией. В раз- витой форме этот процесс можно организовать следующим образом. Пусть z — полный набор факторов, потенциально влияющих на x. Рассмат- ривается процесс обращения матрицы ковариации переменных x, z, в начале ко- торого рядом с этой матрицей записывается единичная матрица. С этой парой мат- риц производятся одновременные линейные преобразования. Известно, что если первую матрицу привести таким образом к единичной, то на месте второй будет по- лучена матрица, обратная к матрице ковариации. Пусть этот процесс не завершен,

242 Глава 7. Основная модель линейной регрессии

и только n 1 строк первой матрицы, начиная с ее второй строки (т.е. со стро- ки первого фактора), преобразованы в орты; z 1 — множество факторов, строки которых преобразованы в орты, z 2 — остальные факторы. Это — ситуация на те- кущем шаге процесса. В начале процесса пара преобразуемых матриц имеет вид (над матрицами по- казаны переменные, которые соответствуют их столбцам):

x z 1 z 2 m m t m t x z 1 z 2 1 0 0 xx 1 2 m 1 M 11 M 12 и 0 I 1 0 ,

M 22 0 0 I 2

где

— дисперсия x, m 1 = 1 Z ˆ X — вектор-столбец коэффициентов ковариации z 1 и x,

m 2 = 1 Z ˆ X — вектор-столбец коэффициентов ковариации z 2 и x,

M 11 = 1 Z ˆt Z ˆ — матрица коэффициентов ковариации z между собой,

M 12 = 1 Z ˆt Z ˆ — матрица коэффициентов ковариации z и z ,

M 22 = 1 Z ˆt Z ˆ — матрица коэффициентов ковариации z между собой.

На текущем шаге эти матрицы преобразуются к виду: x z 1 z 2 m − m t M −1 m m t M −1 m t − m t M −1 M 12 xx 1 1 1 1 1 2 1 1

←−−−−−− c e −2−−−−−→

m 2 − M t M −1 m 1 M t M −1 M 2 − M t M −1 M 12 12 1 12 1 12 1

x z 1 z 2 1 0 0

− M −1 m 1 M −1 − M −1 M 12 1 0 0 I 2

7.3. Независимые факторы: спецификация модели 243

Информация, используемая в шаговой регрессии, расположена в 1-й строке первой матрицы: остаточная дисперсия в текущей регрессии (в столбце x), коэф- фициенты a 1 текущей регрессии при переменных z 1 (в столбцах z 1), коэффи- циенты ce 2 ковариации текущих остатков e с переменными z 2, не включенными в текущую регрессию (в столбцах z 2). Для введения очередного фактора в регрессию (шаг вперед) следует его строку в первой матрице преобразовать в орт, для исключения фактора из регрессии (шаг назад) следует преобразовать в орт его строку во второй матрице. Шаг вперед увеличивает количество элементов в векторе z 1 на единицу и сокращает на единицу количество элементов в векторе z 2. Шаг назад приводит к обратным изменениям. Последствия любого из этих шагов можно оценить по F -критерию, рассчитав показатель pv F c -статистики (информацию для такого расчета дает остаточная дисперсия — первый элемент первой строки первой матрицы). На текущем шаге процесса проверяются последствия введения всех ранее не введенных факторов z 2 и исключения всех введенных факторов z 1. Выби- рается тот вариант, который дает минимальное значение показателя pv. Процесс заканчивается, как только этот показатель перестает падать. В результате опреде- ляется наилучшая регрессия. Такой процесс не приводит, как правило, к включению в регрессию сильно коррелированных факторов, т.е. позволяет решить проблему мультиколлинеарности. Если бы расчеты проводились в стандартизированной шкале (по коэффици- ентам корреляции, а не ковариации), «кандидатом» на введение был бы фактор с максимальным значением показателя в множестве c e 2 (как было показано вы- ше), а на исключение — фактор с минимальным значением показателя в множе- стве a 1. Но даже в этом случае для окончательного выбора (вводить-исключать) и решения вопроса о завершении процесса требуется использование F -критерия. При «работе» с коэффициентами ковариации использование F -критерия необ- ходимо. На последних шагах процесса, при приближении к минимуму критериального показателя pv, его величина меняется, как правило, весьма незначительно. Поэто- му один из возможных подходов к использованию шаговой регрессии заключается в определении некоторого множества регрессий, получаемых на последних шагах процесса, которые практически одинаковы по своему качеству. И на этом мно- жестве следует делать окончательный выбор, пользуясь содержательными крите- риями. Иногда процесс шаговой регрессии предлагают строить на основе t -критерия: фактор вводится в уравнение, если его t -статистика больше некоторой заданной величины t 1, выводится из уравнения, если эта статистика меньше заданной вели- чины t 2; как правило, t 1 > t 2. Такой процесс не гарантирует получение наилучшей

244 Глава 7. Основная модель линейной регрессии

регрессии, его использовали в то время, когда вычислительные возможности были еще слабо развиты, и, в частности, точные значения показателя pv было трудно определить.

Прогнозирование

Пусть получены оценки параметров уравнения (7.11). Задача прогнозирования заключается в определении возможного значения (прогноза) переменной x, объ- ясняемой этой моделью, при некоторых заданных значениях факторов z, которые не совпадают ни с одним из наблюдений в матрице Z. Более того, как прави- ло, z лежит вне области, представляемой матрицей Z. При этом предполагается, что гипотезы g 1 − g 3 по-прежнему выполняются. Обычно термин «прогнозирование» используется в случае, когда наблюдения i = 1 ,..., N в матрице Z даны по последовательным моментам (периодам) вре- мени, и заданные значения факторов z, для которых требуется определить прогноз x, относятся к какому-то будущему моменту времени, большему N (т.е. z лежит вне области, представляемой матрицей Z). Методы прогнозирования могут быть различными. Если применяются отно- сительно простые статистические методы, как в данном случае, то часто исполь- зуют термин «экстраполирование». Если аналогичная задача решается для z, лежащих внутри области, представляемой наблюдениями в матрице Z (например, для «пропущенных» по каким-то причинам наблюдений), то используют термин «интерполирование». Процедуры экстраполирования и интерполирования с ис- пользованием модели (7.11) с формальной точки зрения одинаковы. Итак, задан некоторый z r = [ zr 1 ··· z rn 1], который отличается от всех z i , i = 1 ,..., N (если i — обозначает момент времени, то r > N). x r = z r α + ε r — истинное значение искомой величины,

Предполагаем, что гипотезы g 1 − g 4 выполнены как для i = 1 ,..., N, так и для r > N. Это линейный (относительно случайных величин X) прогноз: xp (7. 26) z LX, r = r он не смещен относительно ожидаемого значения вслед за несмещенностью a: E (x p) = x 0. Его ошибка ε p = x r − x p имеет нулевое математическое ожидание r r r r и дисперсию

2 1+ z r . Z t Z. −1

7.4. Прогнозирование 245 которая минимальна на множестве всех возможных линейных несмещенных про- гнозов.

r = zr (α − a)+ ε r. Поскольку случайные величины a и ε r не зависят друг от друга, σ2 p 2. r r 2 p = E. (ε r ) = E (z r (α − a)(α − a) zr)+ E. ε r . = = zr M a z r + σ2 (7. 29)

zr (Z r Z)−1 z r . r 1+ r

Эта дисперсия минимальна среди всех возможных дисперсий линейных несмещен- ных прогнозов вслед за аналогичным свойством оценок a. Это является прямым следствием того, что оценки МНК относятся к классу BLUE. Для того чтобы в этом убедиться, достаточно в доказательстве данного свойства оценок a, которое приве- дено в п. 7.2, заменить c r на zr .

i i ожидание, но принципиально другую, существенно меньшую, дисперсию:

2 1 − z i . Z t Z. −1 t

a и ε i коррелированы и поэтому:

2 1+ zi (Z r Z)−1 r

(7. 27) = − L ε g4

где o i — i -й орт =

|

|||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|

Последнее изменение этой страницы: 2021-01-08; просмотров: 116; Нарушение авторского права страницы; Мы поможем в написании вашей работы! infopedia.su Все материалы представленные на сайте исключительно с целью ознакомления читателями и не преследуют коммерческих целей или нарушение авторских прав. Обратная связь - 3.145.105.108 (0.388 с.) |

A

A A Однако в эмпирических исследованиях могут возникать ситуации, когда только введение сильно

A Однако в эмпирических исследованиях могут возникать ситуации, когда только введение сильно 2

2 N

N

C

C R ˜2 = 1 − 1 − R 2 N −

R ˜2 = 1 − 1 − R 2 N − R = 1

R = 1 = 0 (7.61)

= 0 (7.61) 1 2

1 2 A

A