Заглавная страница Избранные статьи Случайная статья Познавательные статьи Новые добавления Обратная связь КАТЕГОРИИ: ТОП 10 на сайте Приготовление дезинфицирующих растворов различной концентрацииТехника нижней прямой подачи мяча. Франко-прусская война (причины и последствия) Организация работы процедурного кабинета Смысловое и механическое запоминание, их место и роль в усвоении знаний Коммуникативные барьеры и пути их преодоления Обработка изделий медицинского назначения многократного применения Образцы текста публицистического стиля Четыре типа изменения баланса Задачи с ответами для Всероссийской олимпиады по праву

Мы поможем в написании ваших работ! ЗНАЕТЕ ЛИ ВЫ?

Влияние общества на человека

Приготовление дезинфицирующих растворов различной концентрации Практические работы по географии для 6 класса Организация работы процедурного кабинета Изменения в неживой природе осенью Уборка процедурного кабинета Сольфеджио. Все правила по сольфеджио Балочные системы. Определение реакций опор и моментов защемления |

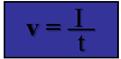

Скорость передачи информации – количество переданной информации в единицу времени.

V — скорость передачи информации, I — количество информации в сообщении, t — время, затраченное на передачу сообщения. Единицей измерения скорости передачи информации является бит в секунду.

В рамках алфавитного (структурного) подхода выделяют три меры информации: 1) Геометрическая. Определяет максимально возможное количество информации в заданных объемах. Мера может быть использована для определения информационной ёмкости памяти компьютера; 2) Комбинаторная. Оценивает возможность представления информации при помощи различных комбинаций информационных элементов в заданном объёме. Комбинаторная мера может использоваться для оценки информационных возможностей некоторого системы кодирования. 3) Аддитивная (мера Хартли). Геометрическая мера определяет максимально возможное количество информации в заданных объёмах. Единица измерения – информационный элемент. Мера может быть использована для определения информационной ёмкости памяти компьютера. В этом случае в качестве информационного элемента выступает минимальная единица хранения – бит. БИТ- это наименьшая единица измерения информации.

Пример 1. Пусть сообщение, состоящее из 14 символов) 5555 6666 888888 закодировано методом кодирования повторений – и имеет вид: 5(4) 6(4) 8(6). Требуется измерить информацию в исходном и закодированном сообщениях геометрической мерой и оценить эффективность кодирования. В качестве информационного элемента зададимся символом сообщения. Тогда: I(исх.) = n(исх.) = 14 символов; I(закод.) = n(закод.) = 12 символов, где I(исх.), I(закод.) – количества информации, соответственно, в исходном и закодированном сообщениях; n(исх.), n(закод.) – длины (объёмы) тех же сообщений, соответственно. Эффект кодирования определяется как разница между I(исх.) и I ( закод.) и составляет 2 символа.

Очевидно, геометрическая мера не учитывает, какими символами заполнено сообщение. Так, одинаковыми по количеству информации, измеренной геометрической мерой, являются, например, сообщения «компьютер» и «программа»; а также 346 и 10В. Комбинаторная мера оценивает возможность представления информации при помощи различных комбинаций информационных элементов в заданном объёме. Использует типы комбинаций элементов и соответствующие математические соотношения, которые приводятся в одном из разделов дискретной математики – комбинаторике.

Комбинаторная мера может использоваться для оценки информационных возможностей некоторого автомата, который способен генерировать дискретные сигналы (сообщения) в соответствии с определенным правилом комбинаторики. Пусть, например, есть автомат, формирующий двузначные десятичные целые положительные числа (исходное множество информационных элементов {0, 1, 2, 3, 4, 5, 6, 7, 8, 9}). В соответствии с положениями комбинаторики, данный автомат генерирует размещения (различаются числа, например, 34 и 43) из 10 элементов (используются 10 цифр) по 2 (по условию задачи, формируются двузначные числа) с повторениями (очевидно, возможны числа, состоящие из одинаковых цифр, например, 33). Тогда можно оценить, сколько различных сообщений (двузначных чисел) может сформировать автомат, иначе говоря, можно оценить информационную ёмкость данного устройства равна 102 = 100. Комбинаторная мера используется для определения возможностей кодирующих систем. Пример 2. Определить емкость ASCII-кода, представленного в двоичной или шестнадцатеричной системе счисления. ASCII-код – это сообщение, которое формируется как размещение с повторениями: 1) для двоичного представления – из информационных элементов {0, 1}, сообщение длиной (объемом) 8 символов; 2) для шестнадцатеричного представления – из информационных элементов {0, 1, 2, …., А, В, С, …. F}, сообщение длиной (объемом) 2 символа. Тогда в соответствии с положениями комбинаторики: I(двоичное) = 28 = 256; I(шестнадцатеричное) = 162 = 256, где I(двоичное), I (шестнадцатеричное) – количества информации, соответственно, для двоичного и шестнадцатеричного представления ASC II - кода. Таким образом, емкость ASC II-кода для двоичного и шестнадцатеричного представления одинакова и равна 256.

Комбинаторная мера является развитием геометрической меры, т. к. помимо длины сообщения учитывает объём исходного алфавита и правила, по которым из его символов строятся сообщения. Ею измеряется информация не конкретного сообщения, а всего множества сообщений, которые могут быть получены.

Единицей измерения информации в комбинаторной мере является число комбинаций информационных элементов. Аддитивная мера называется мерой Хартли. Хартли рассмотрел кодировку сообщения с помощью некоторого набора знаков (если для данного набора установлен порядок следования знаков, то он называется алфавитом). Самой сложной частью работы оказалось определение количества информации, содержащейся в каждом отдельном символе: остальная часть процедуры весьма проста. Алфавит – вся совокупность символов, используемых в некотором языке для представления информации. С целью анализа некоторого текста, введём обозначения: N - мощность алфавита, использованного для написания текста, т.е. число символов в алфавите (размер алфавита); n – число символов в сообщении (длина текста, например, одного слова); I –количество информации в сообщении; i=I /n – информационный вес символа (количество информации в одном символе).

Если речь идёт не об анализе текста, передаваемого в сообщении, а об описании каких-либо событий, то приводимый ниже математический аппарат полностью сохраняется, если под используемыми обозначениями понимать: N – общее число возможных исходов; n - число возможных исходов интересующего нас события (здесь все возможные события считаются равновероятными), I – количество информации о всех случившихся событиях; i – количество информации в сообщении о том, что произошло одно из N событий. Предположим, что какое-то событие имеет N а равновероятных исходов. Пусть такие события наступают в передаваемом по каналам связи сообщении, которое представлено в виде набора некоторых смысловых элементов или символов (например, букв какого-то алфавита). Здесь событием является появление любого символа из алфавита. Пусть далее в языке, использованном для написания текста этого сообщения, общее количество (объём алфавита) смысловых символов (букв) равно N а, а одно сообщение составлено из n элементов (если сообщение состоит из одного слова, то n – количество букв в слове, т.е. длина слова; если сообщение состоит из многих слов, то n – число знаков во всём тексте). Вопрос: как измерить количество информации, которое может быть передано при помощи такого алфавита? Необходимо посчитать число N возможных сообщений, которые могут быть переданы при помощи этого алфавита. Очевидно, что если сообщение формируется из одного символа, то N=N a, если из двух, то N=N a ·N a =N a2. Если сообщение содержит n символов, то число возможных сообщений N=N an. Если сообщение – это текст, состоящий только из отдельных букв алфавита, причём вероятности появления конкретной буквы в тексте одинаковы, n=1 (текст – случайный набор букв), то N=Na. Если события передаются последовательностью цифр некоторой разрядности, то, естественно, N≠Na, а n-разрядность числа. Так, например, с помощью двухразрядного десятичного числа (n= 2, Na = 10) можно записать N = 102 = 100 различных чисел от 0 до 99. В частности, при средней длине русского слов» n = 5 букв и алфавите в N a = 32 буквы можно составить 33,5 млн. различных слов. Казалось бы, искомая мера количества информации найдена. Её можно понимать как меру неопределенности исхода опыта, если под опытом подразумевать случайный выбор какого-либо сообщения из некоторого числа возможных. Мера это, однако, не удобна, так как:

1) Не выполняется условие пропорциональности между длиной слова (длительностью сигнала) и количеством содержащейся в нём информации. Между тем удвоение времени передачи сообщений должно приводить к удвоению количества передаваемой информации. Для двух независимых источников сообщений (или алфавита) с N 1 и N 2 числом возможных сообщений, общее число возможных сообщений N = N 1 ·N 2, в то время как логичнее было бы считать, что количество информации, получаемое от двух независимых источников, должно быть не произведением, а суммой составляющих величин 2) При наличии алфавита, состоящего из одного символа, т.е. когда N a = 1, возможно появление только этого символа. Следовательно, неопределенности в этом случае не существует, и появление этого символа не несёт никакой информации. Между тем, значение N при N a = 1 не обращается в нуль. Р. Хартли предложил в качестве меры количества информации использовать логарифм числа возможных сообщений Выход из положения был найден Р. Хартли, который предложил информацию I, приходящуюся на одно сообщение, определять логарифмом по некоторому основанию а от общего числа возможных сообщений N: I(N) = loga N Если же всё множество возможных сообщений состоит из одного (N = N a = 1), то I(N) = log1 = 0, что соответствует отсутствию информации в этом случае. При наличии независимых источников информации с N 1 и N 2 числом возможных сообщений I(N) = log N = log N 1 N 2 = log N 1 + log N 2, т.е. количество информации, приходящееся на одно сообщение, равно сумме количеств информации, которые были бы получены от двух независимых источников, взятых порознь. Формула, предложенная Хартли, удовлетворяет предъявленным требованиям. Поэтому её можно использовать для измерения количества информации. Полная информация, содержащаяся в сообщении, определяется как количество сведений (при их длине n) пропорциональное числу смысловых символов N формулой Хартли: I =nlog a N Согласно этому соотношению, количество информации в передаваемом сообщении пропорционально его длительности (числу символов). Выбор основания логарифма а влияет только на размерность, т.е. на единицу измерения количества информации. Наиболее удобным оказалось основание логарифма а = 2.

Хартли впервые ввёл специальное обозначение для количества информации – I и предложил следующую логарифмическую зависимость между количеством информации и мощностью исходного алфавита (для равновероятных событий, а у Хартли они именно равновероятные, N=N a): I=nlogaN=n·i т. е. NnIialog Количество информации, содержащееся в одном элементе сигнала, называют удельной информативностью или энтропией сигнала: NnIHi a log По существу энтропия есть мера неопределенности или мера недостающей информации исследуемого процесса (сообщения). В частности, энтропия русского алфавита (32 знака) равна Н = 5 бит/символ. inI aaN где а – основание логарифма. Если алфавит построен на двоичной системе {0,1}, т.е. а =2, то N=2 i, и формула Хартли приобретает вид I = n log 2 N При n = 1; N = 2 и основании логарифма, равном а =2, имеем I = 1⋅log22 = 1 - аналитическое определение бита по Хартли: это количество информации, которое содержится в двоичной цифре. Единицей измерения информации в аддитивной мере является бит. Если хотят отразить подход Хартли на языке тории вероятности, то вводят понятие вероятности реализации одного из N событий, (по Хартли они имеют равновероятный исход, N a =N), Np 1=. Тогда pN 1= и Nnp =, где n – число возможных исходов интересующего нас события и i =log 2 N=log 2 N a =log 2 (1/ р) =- log 2 р т.е. количество информации на каждый равновероятный сигнал равно отрицательному логарифму от вероятности отдельного сигнала. Из формулы pi 1log 2 очевидно, что чем вероятнее событие, тем меньше информации оно несёт. Полученная формула позволяет для некоторых случаев определить количество информации. Однако для практических целей необходимо задаться единицей его измерения. Для этого предположим, что информация – это устраненная неопределенность. Тогда в простейшем случае неопределенности выбор будет производиться между двумя взаимоисключающими друг друга равновероятными сообщениями, например между двумя качественными признаками: положительным и отрицательным импульсами, импульсом и паузой и т.п. Количество информации, переданное в этом простейшем случае, наиболее удобно принять за единицу количества информации. Именно такое количество информации может быть получено, если в формуле Хартли брать логарифм по основанию а= 2. Тогда I = – log 2 p = – log 2 (1/2) = log 2 2 = 1 Полученная единица количества информации, представляющая собой выбор из двух равновероятных событий, получила название двоичной единицы, или бита. За единицу количества информации в системах передачи дискретных и цифровых сообщений был принят один бит (binary digit - двоичная цифра) - двоичный разряд - символ, принимающий значение 0 или 1. Так, символы 101 есть 3-битовое число. Бит является не только единицей количества информации, но и единицей измерения степени неопределенности. При этом имеется в виду неопределенность, которая содержится в одном опыте, имеющем два равновероятных исхода.

Данная мера представления является универсальной и позволяет сравнить различные сообщения и количественно определить ценность различных источников информации, оценить величину её потерь при передаче, приёме, обработке, хранении, использовании и т. д. Как уже упоминалось, в цифровой технике (компьютерах) в качестве единицы представления данных используется байт (byte - слог) - слово (набор) из восьми двоичных разрядов (битов). Легко посчитать, что байтом можно передать одно из 28 = 256 различных сообщений. На количество информации, получаемой из сообщения, влияет фактор неожиданности его для получателя, который зависит от вероятности получения того или иного сообщения. Чем меньше эта вероятность, тем сообщение более неожиданно и, следовательно, более информативно. Сообщение, вероятность которого высока и, соответственно, низка степень неожиданности, несет немного информации. Р.Хартли понимал, что сообщения имеют различную вероятность и, следовательно, неожиданность их появления для получателя неодинакова. Но, определяя количество информации, он пытался полностью исключить фактор «неожиданности». Поэтому формула Хартли позволяет определить количество информации в сообщении только для случая, когда появление символов равновероятно и они статистически независимы. На практике эти условия выполняются редко. При определении количества информации необходимо учитывать не только количество разнообразных сообщений, которые можно получить от источника, но и вероятность их получения. Для событий, вероятность наступления которых не одинакова, формулу для расчёта вероятности, предложил К.Шеннон уже не как аддитивную, а как вероятностную меру. При выводе своей формулы Хартли предполагал, что буквы в тексте появляются с одинаковой вероятностью. Это - грубая модель, но зато очень простая. Если применять формулу Хартли не к тексту, а к событиям, то она применима исключительно для анализа равновероятных событий. Для событий, реализующихся с разной вероятностью, вычисление информации следует проводить по формуле Шеннона. Пример 3. Рассчитать количество информации, которое содержится в шестнадцатеричном и двоичном представлении ASCII-кода для числа 1. В соответствии с таблицей ASCII-кодов имеем: шестнадцатеричное представление числа 1 – 31, двоичное представление числа 1 – 00110001. Тогда по формуле Хартли получаем: для шестнадцатеричного представления I = 2log216 = 8 бит; для двоичного представления I = 8 log22 = 8 бит. Таким образом, разные представления ASCII-кода для одного символа содержат одинаковое количество информации, измеренной аддитивной мерой.

В целом алфавитный подход основан на определении количества информации в каждом из знаков дискретного сообщения с последующим подсчётом количества этих знаков в сообщении. В простейшем варианте он заключается подсчёте числа символов в сообщении, т. е. связан только с длиной сообщения и не учитывает его содержания. Длина сообщения зависит от числа знаков, употребляемых для записи сообщения. Например, слово «мир» в русском алфавите записывается тремя знаками, в английском - пятью (peace), а в КОИ -8 - двадцатью четырьмя битами (111011011110100111110010).

|

|||||||||

|

Последнее изменение этой страницы: 2020-11-11; просмотров: 286; Нарушение авторского права страницы; Мы поможем в написании вашей работы! infopedia.su Все материалы представленные на сайте исключительно с целью ознакомления читателями и не преследуют коммерческих целей или нарушение авторских прав. Обратная связь - 18.224.214.215 (0.024 с.) |

, где

, где