Заглавная страница Избранные статьи Случайная статья Познавательные статьи Новые добавления Обратная связь КАТЕГОРИИ: ТОП 10 на сайте Приготовление дезинфицирующих растворов различной концентрацииТехника нижней прямой подачи мяча. Франко-прусская война (причины и последствия) Организация работы процедурного кабинета Смысловое и механическое запоминание, их место и роль в усвоении знаний Коммуникативные барьеры и пути их преодоления Обработка изделий медицинского назначения многократного применения Образцы текста публицистического стиля Четыре типа изменения баланса Задачи с ответами для Всероссийской олимпиады по праву

Мы поможем в написании ваших работ! ЗНАЕТЕ ЛИ ВЫ?

Влияние общества на человека

Приготовление дезинфицирующих растворов различной концентрации Практические работы по географии для 6 класса Организация работы процедурного кабинета Изменения в неживой природе осенью Уборка процедурного кабинета Сольфеджио. Все правила по сольфеджио Балочные системы. Определение реакций опор и моментов защемления |

Лінійна передавальна функція

Сигнал на виході нейрона лінійно пов'язаний із ваговою сумою сигналів на його вході.

, де t - параметр функції. В штучних нейронних мережах із шаруватою структурою, нейрони з передавальними функціями такого типу, як правило, складають вхідний шар. Крім простої лінійної функції можуть бути використовуватись також її модифікації. Наприклад напівлінійна функція (якщо її аргумент менше нуля, то вона дорівнює нулю, а в інших випадках, поводить себе як лінійна) або крокова (лінійна функція з насиченням), яку можна виразити формулою[9]:

При цьому можливий зсув функції по обох осях (як зображено на малюнку). Недоліками крокової і напівлінійних активаційних функцій щодо лінійної можна назвати те, що вони не є диференційовними на всій числової осі, а отже не можуть бути використані при навчанні за деякими алгоритмам.

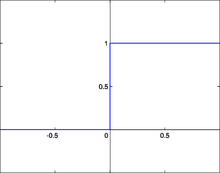

Порогова функція активації [ред.]Порогова передавальна функція Інша назва - Функція Хевісайда. Являє собою перепад. До тих пір поки зважений сигнал на вході нейрона не досягає певного рівня

Тут

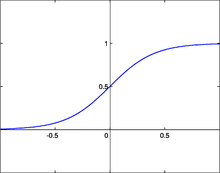

Сигмоїдна функція активації [ред.]Сигмоїдальна передавальна функція Детальніше: Сигмоїда Один із найчастіше використовуваних, в цей час, типів передавальних функцій. Введення функцій сигмоїдального типу було обумовлене обмеженістю нейронних мереж із пороговою функцією активації нейронів - за такої функції активації будь-який із виходів мережі дорівнює або нулю, або одиниці, що обмежує використання мереж не в задачах класифікації. Використання сигмоїдальних функцій дозволило перейти від бінарних виходів нейрона до аналогових [11]. Функції передачі такого типу, як правило, властиві нейронам, що знаходяться у внутрішніх шарах нейронної мережі.

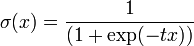

[ред.]Логістична функція Математично цю функцію можна виразити так:

Тут t - це параметр функції, що визначає її крутизну. Коли t прямує до нескінченності, функція вироджується в порогову. При

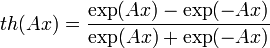

Те, що похідна цієї функції може бути виражена через її значення полегшує використання цієї функції при навчанні мережі за алгоритмом зворотного поширення [12]. Особливістю нейронів з такою передавальною характеристикою є те, що вони посилюють сильні сигнали істотно менше, ніж слабкі, оскільки області сильних сигналів відповідають пологим ділянках характеристики. Це дозволяє запобігти насиченню від великих сигналів [13]. [ред.]Гіперболічний тангенс Використання функції гіперболічного тангенса

відрізняється від розглянутої вище логістичної кривої тим, що його область значень лежить в інтервалі (-1; 1). Оскільки є вірним наступне співвідношення

то обидва графіки відрізняються лише масштабом осей. Похідна гіперболічного тангенса, зрозуміло, теж виражається квадратичною функцією значення; властивість протистояти насиченню також має місце. [ред.]Радіально-базисна функція передачі [14] Цей тип функцій приймає як аргумент відстань між вхідним вектором і деяким наперед заданими центром активаційний функції. Значення цієї функції тим вище, чим ближче до центру вхідний вектор [15]. Як радіально-базисної можна, наприклад, використовуватифункцію Гауса:

Тут

Тут У реальних мережах активаційна функція цих нейронів може відображати розподіл ймовірністі будь-якої випадкової величини, або позначати будь-які евристичні залежності між величинами. [ред.]Інші функції передачі Перераховані вище функції становлять лише частину від безлічі передавальних функцій, що використовуються в цей час. До числа інших передавальних функцій входять такі як [9]: § Експонента § Тригонометричний синус; § Модульна: § Квадратична.

|

||||||

|

Последнее изменение этой страницы: 2017-02-06; просмотров: 563; Нарушение авторского права страницы; Мы поможем в написании вашей работы! infopedia.su Все материалы представленные на сайте исключительно с целью ознакомления читателями и не преследуют коммерческих целей или нарушение авторских прав. Обратная связь - 52.14.22.250 (0.006 с.) |

- сигнал на виході дорівнює нулю. Як тільки сигнал на вході нейрона перевищує зазначений рівень - вихідний сигнал стрибкоподібно змінюється на одиницю. Найперший представник шаруватих штучних нейронних мереж -перцептрон [10] складався виключно з нейронів такого типу [4]. Математична запис цієї функції виглядає так:

- сигнал на виході дорівнює нулю. Як тільки сигнал на вході нейрона перевищує зазначений рівень - вихідний сигнал стрибкоподібно змінюється на одиницю. Найперший представник шаруватих штучних нейронних мереж -перцептрон [10] складався виключно з нейронів такого типу [4]. Математична запис цієї функції виглядає так:

- зсув функції активації щодо горизонтальної осі, відповідно під

- зсув функції активації щодо горизонтальної осі, відповідно під  слід розуміти зважену суму сигналів на входах нейрона без урахування цього доданку. З огляду на те, що ця функція не є диференційовною на всій осі абсцис, її не можна використовувати в мережах, що навчаються за алгоритмом зворотного поширення помилки та іншим алгоритмам, що вимагають диференційованої передавальної функції.

слід розуміти зважену суму сигналів на входах нейрона без урахування цього доданку. З огляду на те, що ця функція не є диференційовною на всій осі абсцис, її не можна використовувати в мережах, що навчаються за алгоритмом зворотного поширення помилки та іншим алгоритмам, що вимагають диференційованої передавальної функції.

сигмоїда вироджується в постійну функцію із значенням 0,5. Область значень даної функції знаходиться в інтервалі (0,1). Важливою перевагою цієї функції є простота її похідної:

сигмоїда вироджується в постійну функцію із значенням 0,5. Область значень даної функції знаходиться в інтервалі (0,1). Важливою перевагою цієї функції є простота її похідної:

,

,

- відстань між центром

- відстань між центром  і вектором вхідних сигналів

і вектором вхідних сигналів  . Скалярний параметр

. Скалярний параметр  визначає швидкість спадання функції при віддалені вектора від центру і називається шириною вікна, параметр

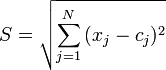

визначає швидкість спадання функції при віддалені вектора від центру і називається шириною вікна, параметр  визначає зсув активаційний функції по осі абсцис. Мережі, з нейронами, що використовують такі функції, називаються RBF-мережами. В якості відстані між векторами можуть бути використані різні метрики [16], зазвичай використовується евклідова відстань:

визначає зсув активаційний функції по осі абсцис. Мережі, з нейронами, що використовують такі функції, називаються RBF-мережами. В якості відстані між векторами можуть бути використані різні метрики [16], зазвичай використовується евклідова відстань:

- j-та компонента вектора, поданого на вхід нейрона, а

- j-та компонента вектора, поданого на вхід нейрона, а  - j-та компонента вектора, що визначає положення центру передавальної функції. Відповідно, мережі з такими нейронами називаються ймовірносними та регресійними[17].

- j-та компонента вектора, що визначає положення центру передавальної функції. Відповідно, мережі з такими нейронами називаються ймовірносними та регресійними[17]. ;

; ;

;