Заглавная страница Избранные статьи Случайная статья Познавательные статьи Новые добавления Обратная связь КАТЕГОРИИ: ТОП 10 на сайте Приготовление дезинфицирующих растворов различной концентрацииТехника нижней прямой подачи мяча. Франко-прусская война (причины и последствия) Организация работы процедурного кабинета Смысловое и механическое запоминание, их место и роль в усвоении знаний Коммуникативные барьеры и пути их преодоления Обработка изделий медицинского назначения многократного применения Образцы текста публицистического стиля Четыре типа изменения баланса Задачи с ответами для Всероссийской олимпиады по праву

Мы поможем в написании ваших работ! ЗНАЕТЕ ЛИ ВЫ?

Влияние общества на человека

Приготовление дезинфицирующих растворов различной концентрации Практические работы по географии для 6 класса Организация работы процедурного кабинета Изменения в неживой природе осенью Уборка процедурного кабинета Сольфеджио. Все правила по сольфеджио Балочные системы. Определение реакций опор и моментов защемления |

Классификация видов и методов измерений. Классификация погрешностей измерений.

Классификация видов и методов измерений. Измерения можно классифицировать по различным признакам: • по числу измерений – однократные, когда измерения выполняют один раз, и многократные – ряд однократных измерений физической величины одного и того же размера; • характеристике точности – равноточные – ряд измерений какой-либо величины, выполненных одинаковыми по точности средствами измерений в одних и тех же условиях с одинаковой тщательностью, и неравноточные, когда ряд измерений какой-либо величины выполняется различающимися по точности средствами измерений и в разных условиях; • характеру изменения во времени измеряемой величины – статические, когда значение физической величины считается неизменным на протяжении времени измерения, и динамические – измерение изменяющейся по размеру физической величины. • способу представления результатов измерений – абсолютные – измерение величины в ее единицах, и относительные – измерение изменения величины по отношению к одноименной величине, принимаемой за исходную. Относительные измерения при прочих равных условиях могут быть выполнены более точно, чем абсолютные, так как в суммарную погрешность не входит погрешность меры величины. Виды измерений. По способу получения результата все измерения подразделяют на виды: прямые и косвенные, совокупные и совместные. Прямые измерения – измерения, при которых искомое значение физической величины получают непосредственно из опытных данных. К прямым измерениям относятся, например, нахождение значения напряжения, тока, мощности по шкале прибора. Косвенные измерения – определение искомого значения физической величины на основании результатов прямых измерений других физических величин, функционально связанных с искомой величиной. При этом числовое значение искомой величины находится расчетным путем Косвенные измерения, в свою очередь, подразделяют на совокупные и совместные. Совокупные измерения – это проводимые одновременно измерения нескольких одноименных величин, при которых искомые значения величин определяют путем решения системы уравнений, получаемых при измерениях этих величин в различных сочетаниях. Совместные измерения – это производимые одновременно измерения двух или нескольких не одноимённых величин для определения зависимости между ними. Числовые значения искомых величин, как и в случае совокупных измерений, определяются из системы уравнений, связывающих значения искомых величин со значениями величин, измеренных прямым (или косвенным) способом. Число уравнений должно быть не меньше числа искомых величин.

Методы измерения. Метод измерения – это прием или совокупность приемов сравнения измеряемой физической величины с ее единицей в соответствии с реализованным принципом измерений. Методы измерения можно классифицировать по различным признакам: · по физическому принципу, положенному в основу измерения, их подразделяют на электрические, механические, магнитные, оптические и т.д.; · степени взаимодействия средства и объекта измерения – контактный и бесконтактный. · режиму взаимодействия средства и объекта измерения – статические и динамические; · виду измерительных сигналов – аналоговые и цифровые; · организации сравнения измеряемой величины с мерой – метод непосредственной оценки и метод сравнения. Метод непосредственной оценки (отсчета) – метод измерений, при котором значение величины определяют непосредственно по показывающему средству измерений. Метод отличается своей простотой, точность его невысока. Метод сравнения с мерой – метод измерения, при котором измеряемая величина сравнивается с величиной воспроизводимой мерой. Эти методы сложны, но характеризуются высокой точностью. Они подразделяются на дифференциальные, нулевые, замещения и совпадений. Дифференциальный (разностный) метод заключается в том, что измерительным прибором оценивается разность между измеряемой величиной и однородной величиной, имеющей известное значение. Точность метода возрастает с уменьшением разности между сравниваемыми величинами. Нулевой метод является частным случаем дифференциального метода и заключается в том, что результирующий эффект воздействия измеряемой величины и меры на прибор сравнения доводится до нуля (например, измерение электрического сопротивления мостом с полным его уравновешиванием).

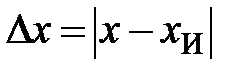

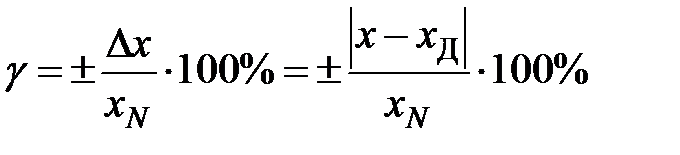

Метод измерения замещения заключается в том, что измеряемая величина замещается мерой с известным значением величины. Метод используется, например, при измерении индуктивности, емкости. Метод совпадений состоит в том, что измеряют разность между искомой величиной и образцовой мерой, используя совпадения отметок или периодических сигналов. Метод используется, например, для измерения перемещений, периода, частоты. Классификация погрешностей измерений. Процедура измерения состоит из следующих этапов: принятие модели объекта измерения, выбор метода измерения, выбор средства измерений, проведение эксперимента для получения результата. Все эти составляющие приводят к тому, что результат измерения отличается от истинного значения измеряемой величины на некоторую величину, называемую погрешностью измерения. Измерение можно считать законченным, если определена измеряемая величина и указана возможная степень ее отклонения от истиною значения. Следует различать погрешность средства измерений и погрешность результата измерения этим же средством измерений. Погрешности измерений зависят от метрологических характеристик используемых средств измерений, совершенства выбранного метода измерений, внешних условий, а также от свойств объекта измерения и измеряемой величины. Погрешности измерений обычно превышают погрешности используемых средств измерений, однако, используя специальные методы устранения ряда погрешностей и статистическую обработку данных многократных наблюдений, можно в некоторых случаях получить погрешность измерения меньше погрешности используемых СИ. По способу выражения погрешности средств измерений подразделяются на абсолютные, относительные и приведенные. Погрешность средства измерений – разность между показанием средства измерений По способу нормирования метрологических характеристик выделяют: абсолютную, относительную и приведенную погрешность средства измерений. Абсолютная погрешность средства измерений – погрешность средства измерений, выраженная в единицах измеряемой физической величины. Абсолютная погрешность средства измерений определяют по такой же формуле, как и погрешность средства измерений: Абсолютная погрешность средства измерений может быть задана (ГОСТ8.401-80): а) либо одним числом (линия 1на рисунке 1.1): б) либо в виде линейной зависимости (линии 2 и 3, рисунок 1.1): в) в виде функции Рисунок 1.1 – Составляющие погрешности средств измерений: 1 – только аддитивная; 2 – только мультипликативная; 3 – аддитивная и мультипликативная Если значение погрешности не изменяется во всем диапазоне измерения (линия 1, рисунок 1.1), например, из-за трения в опорах, то такая погрешность называется аддитивной (или погрешностью нуля). Если погрешность изменяется пропорционально измеряемой величине (линия 2, рисунок 1.1), то ее называют мультипликативной (погрешность чувствительности). В большинстве случаев аддитивная и мультипликативная составляющие присутствуют одновременно (линия 3, рисунок 1.1).

Поскольку абсолютная погрешность средств измерений выражается в абсолютных единицах физической величины, то это не дает возможность сравнить СИ, измеряющие разные физические величины. Для этой цели используют относительные погрешности. Относительная погрешность средства измерений – погрешность средства измерений, выраженная отношением абсолютной погрешности средства измерений Относительная погрешность средства измерений определяется Эта формула показывает, что для одного и того же СИ В СИ с преобладающей мультипликативной погрешностью удобнее нормировать предел допустимой относительной погрешности Для нормирования погрешностей с аддитивной и мультипликативной составляющими (рисунок 1.4)принята более сложная зависимость. Действительно, пусть

Чтобы связать

Рисунок 1.2 – Нормирование погрешностей СИ аддитивной составляющей:

Рисунок 1.3 – Нормирование погрешностей СИ с мультипликативной составляющей Тогда Обозначим

Из этой формулы следует, что при Физически величина

Рисунок 1.4 – Нормирование погрешностей СИ с аддитивной и мультипликативной составляющими

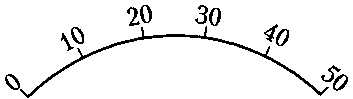

Формула В документациях на СИ должно быть установлено минимальное значение Приведенная погрешность средства измерений – относительная погрешность, выраженная отношением абсолютной погрешности Нормирующее значение Различают равномерные (рисунок 1.5, а, б, в, г)и неравномерные шкалы. Последние делятся на существенно неравномерные и степенные.

а) б) в)

г) д) е) Рисунок 1.5 – Виды шкал средств измерений Под существенно неравномерной шкалой понимают шкалу с сужающимися делениями, на которой отметка, соответствующая полусумме начального и конечного значения рабочей части шкалы, расположена между 65 и 100% длины этой рабочей части (рисунок 1.5 д). Под степенной шкалой понимают шкалу с расширяющимися или сужающимися делениями, но не попадающими под определение существенно неравномерных (рисунке1.5 е). Тогда нормирующее значение 1) конечному значению рабочей части шкалы 2) сумме конечных значений шкалы (без учета знака), если нулевая отметка внутри шкалы (рисунок 1.5 в – 3) длине шкалы, если она существенно неравномерна. В этом случае, поскольку длина выражается в миллиметрах, то абсолютную погрешность надо выражать в миллиметрах (рисунок 1.5 д); 4) номинальному значению х,если СИ предназначено для измерения отклонения измеряемой величины от номинального значения. Все погрешности СИ в зависимости от внешних условий делят на основные и дополнительные. Основная погрешность средства измерений – погрешность средства измерений, применяемого в нормальных условиях. Как привило, нормальными условиями эксплуатации являются: температура 293±5 К или 20±5 С, относительная влажность воздуха 65±15% при 20 °С, напряжение в сети питания 220 В±10% с частотой 50 Гц±1%, атмосферное давление от 97,4 до 104,0 кПа, отсутствие электрических и магнитных полей (наводок). В рабочих условиях, зачастую отличающихся от нормальных более широким диапазоном влияющих величин, при необходимости нормируется дополнительная погрешность СИ.

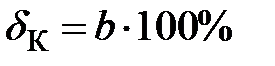

Дополнительная погрешность средства измерений – составляющая погрешности средства измерений, возникающая дополнительно к основной погрешности вследствие отклонения какой-либо из влияющих величин от нормального ее значения или вследствие ее выхода за пределы нормальной области значений. Вследствие сложности разделения дополнительных и основных погрешностей поверку СИ выполняют только при нормальных условиях (т.е. дополнительные погрешности исключены). По способу выявления погрешности СИ делят на случайные и систематические. Случайная погрешность средства измерений – составляющая погрешности средства измерений, изменяющаяся случайным образом. Систематическая погрешность средства измерений – составляющая погрешности средства измерений, принимаемая за постоянную или закономерную изменяющуюся. Систематическую погрешность средства измерений делят на методическую и инструментальную. По характеру режима измерений погрешности СИ делят на статические и динамические. Статическая погрешность средства измерений – погрешность средства измерений, применяемого при измерении физической величины, принимаемой за неизменную. Динамическая погрешность средства измерений – погрешность средства измерений, возникающая при измерении изменяющейся (в процессе измерений) физической величины. Класс точности средств измерений – обобщенная характеристика данного типа средств измерений, как правило, отражающая уровень их точности, выражаемая пределами допускаемых основной и дополнительных погрешностей, а также другими характеристиками, влияющими на точность. Класс точности СИ включает в себя систематическую (основную) и случайную (вариацию показаний) погрешности. Однако он не является непосредственной характеристикой точности измерений, выполняемых с помощью этих СИ, поскольку точность измерения зависит еще от ряда факторов (метода измерения, взаимодействия СИ с объектом, условий измерения и т.д.). ГОСТ 8.401-80 в качестве основных устанавливает следующие виды классов точности СИ: – для пределов допускаемой абсолютной погрешности в единицах измеряемой величины или делениях шкалы; – для пределов допускаемой относительной погрешности в виде ряда чисел

где А = 1; 1,5; (1,6); 2; 2,5; (3); 4; 5 и 6; значения 1,6 и 3 – допускаемые, но не рекомендуемые; п = 1; 0; -1; -2;...; – для пределов допускаемой приведенной погрешности с тем же рядом: Абсолютная погрешность может выражаться одним числом Класс точности через относительную погрешность СИ назначается двумя способами. 1. Если погрешность СИ имеет в основном мультипликативную составляющую, то пределы допускаемой основной относительной погрешности устанавливают по формуле

Так обозначают классы точности мостов переменного тока, счетчиков электроэнергии, делителей напряжения, измерительных трансформаторов и др. 2. Если СИ имеют как мультипликативную, так и аддитивную составляющие, то класс точности обозначается двумя цифрами, соответствующими значениями

Здесь Наиболее широкое распространение (особенно для аналоговых СИ) получило нормирование класса точности по приведенной погрешности:

Условное обозначение класса точности в этом случае зависит от нормирующего значения Отрицательное влияние аддитивной составляющей погрешности заключается в том, что она не позволяет использовать одно и тоже СИ для измерения как больших, так и малых величин. Поэтому на начальной части шкалы СИ измерения, как правило, недопустимы. Из формулы относительной погрешности Рисунок 1.6 Оценка порога чувствительности При уменьшении измеряемой величины от Тогда, задаваясь некоторым значением относительной погрешности Таким образом, если класс точности СИ установлен по наибольшему допускаемому приведенному значению погрешности, а для оценки погрешности конкретного измерения необходимо знать значение абсолютной Для некоторых СИ характерна сложная зависимость относительной погрешности от измеряемой величины или влияющих факторов, которая приводит к логарифмической характеристике точности. В основном это широкодиапазонные СИ, например, мосты постоянного тока, мосты сопротивлений, цифровые частотомеры и т.п. Для них ГОСТ 8.401–80 допускает нормирование классов точности трехчленной формулой

где Например, у широкодиапазонного моста сопротивлений в технической документации указано, что относительная погрешность не превосходит значений в диапазонах: При Контрольные вопросы 1 Дайте определение понятиям «измерение», «физическая величина». 2 Приведите классификацию погрешностей измерений. 3 Как определить цену деления шкалы прибора? 4 Что характеризует класс точности прибора и как он обозначается для различных средств измерений? 5 Перечислите классы точности электромеханических измерительных приборов.

Лекция 2

|

|||||||||

|

Последнее изменение этой страницы: 2017-02-05; просмотров: 2110; Нарушение авторского права страницы; Мы поможем в написании вашей работы! infopedia.su Все материалы представленные на сайте исключительно с целью ознакомления читателями и не преследуют коммерческих целей или нарушение авторских прав. Обратная связь - 3.145.36.10 (0.074 с.) |

и истинным (действительным)

и истинным (действительным)  (

( ) значением измеряемой физической величины. В результате чего погрешность средства измерений определяют по формуле:

) значением измеряемой физической величины. В результате чего погрешность средства измерений определяют по формуле:  или

или  .

. или

или

;

; ;

;  ;

; или графика, таблицы.

или графика, таблицы. к результату измерений

к результату измерений  или к действительному

или к действительному  значению измеренной физической величины.

значению измеренной физической величины. или

или  .

. уменьшается с ростом

уменьшается с ростом  и приближается к бесконечности при

и приближается к бесконечности при  →0, т.е. при измерении на начальном участке шкалы с начальной нулевой отметкой погрешности измерения могут быть сколь угодно велики. Поэтому в метрологии существует принцип запрета измерений на таких участках шкалы СИ. Выбор вида нормирования погрешности зависит от характера ее изменения по диапазону измерения. Если СИ имеет только аддитивную составляющую (или мультипликативной можно пренебречь), то предел допускаемой абсолютной погрешности

→0, т.е. при измерении на начальном участке шкалы с начальной нулевой отметкой погрешности измерения могут быть сколь угодно велики. Поэтому в метрологии существует принцип запрета измерений на таких участках шкалы СИ. Выбор вида нормирования погрешности зависит от характера ее изменения по диапазону измерения. Если СИ имеет только аддитивную составляющую (или мультипликативной можно пренебречь), то предел допускаемой абсолютной погрешности  = const, а

= const, а  будет изменяться по гиперболе (рисунок 1.2). В этом случае удобнее нормировать абсолютную погрешность

будет изменяться по гиперболе (рисунок 1.2). В этом случае удобнее нормировать абсолютную погрешность  .

. = const (рисунок 1.3).Таким способом нормируют счетчики электроэнергии, мосты постоянного и переменного тока.

= const (рисунок 1.3).Таким способом нормируют счетчики электроэнергии, мосты постоянного и переменного тока. ,тогда

,тогда

с конечным значением

с конечным значением  шкалы, к последнему уравнению прибавим и вычтем величину

шкалы, к последнему уравнению прибавим и вычтем величину  =const.

=const. – больший по модулю из пределов измерения,

– больший по модулю из пределов измерения, – отн. погрешность при

– отн. погрешность при

.

. и

и  = const. Откуда

= const. Откуда .

. относительная погрешность равна

относительная погрешность равна  .

. есть относительная погрешность в начале диапазона

есть относительная погрешность в начале диапазона  измерения, величина

измерения, величина  – относительная погрешностьв конце диапазона только мультипликативной составляющей, величина

– относительная погрешностьв конце диапазона только мультипликативной составляющей, величина  – приведенная погрешность только аддитивной составляющей.

– приведенная погрешность только аддитивной составляющей. применяется для нормирования погрешностей высокоточных СИ – цифровых СИ, многозначных мер сопротивления и т.п.

применяется для нормирования погрешностей высокоточных СИ – цифровых СИ, многозначных мер сопротивления и т.п. , начиная от которого применим принятый способ выражения пределов допускаемой относительной погрешности. Указание только абсолютной погрешности не позволяет сравнивать между собой по точности СИ с разным пределом измерений, а указание относительной погрешности также ограничено из-за непостоянства величины

, начиная от которого применим принятый способ выражения пределов допускаемой относительной погрешности. Указание только абсолютной погрешности не позволяет сравнивать между собой по точности СИ с разным пределом измерений, а указание относительной погрешности также ограничено из-за непостоянства величины  . Поэтому получило большое распространение нормирование приведенной погрешности.

. Поэтому получило большое распространение нормирование приведенной погрешности. средства измерений к условно принятому значению величины, постоянному во всем диапазоне измерений или в части диапазона, и определяется по формуле

средства измерений к условно принятому значению величины, постоянному во всем диапазоне измерений или в части диапазона, и определяется по формуле  .

. выбирают по-разному в зависимости от вида и характера шкалы прибора.

выбирают по-разному в зависимости от вида и характера шкалы прибора.

принимается равным:

принимается равным: , если нулевая отметка на краю или вне рабочей части шкалы (равномерная шкала рисунок 1.5 а –

, если нулевая отметка на краю или вне рабочей части шкалы (равномерная шкала рисунок 1.5 а –  = 50; рисунок 1.5 б –

= 50; рисунок 1.5 б –  = 55; степенная шкала –

= 55; степенная шкала –  = 4 на рисунке 1.5 е)

= 4 на рисунке 1.5 е) = 20 + 20 = 40; рисунок 1.5 г –

= 20 + 20 = 40; рисунок 1.5 г –  = =20 + 40 = 60);

= =20 + 40 = 60); ,

, .

. при неизменных границах, двучленом

при неизменных границах, двучленом  – при линейном изменении границ абсолютной погрешности (рисунок 1.1), или в виде таблицы, графика функции при нелинейном изменении границ (таблица 1.1, рисунок 1.6).

– при линейном изменении границ абсолютной погрешности (рисунок 1.1), или в виде таблицы, графика функции при нелинейном изменении границ (таблица 1.1, рисунок 1.6). .

. и

и  формулы

формулы

и

и  выражаются также через ряд

выражаются также через ряд  . Причем, как правило,

. Причем, как правило,  . Например, класс точности 0,02/0,01 означает, что

. Например, класс точности 0,02/0,01 означает, что  , a

, a  , т.е. значение относительной погрешности в начале диапазона измерения

, т.е. значение относительной погрешности в начале диапазона измерения  = 0,02%, а в конце –

= 0,02%, а в конце –  = 0,01%.

= 0,01%. .

. , т.е. от шкалы СИ. Если

, т.е. от шкалы СИ. Если  представляется в единицах измеряемой величины, то класс точности обозначается числом, совпадающим с пределом допускаемой приведенной погрешности. Например, класс 1,5 означает, что

представляется в единицах измеряемой величины, то класс точности обозначается числом, совпадающим с пределом допускаемой приведенной погрешности. Например, класс 1,5 означает, что  = 1,5%. Если

= 1,5%. Если  – длина шкалы (например, у амперметров), то класс 1,5 означает, что

– длина шкалы (например, у амперметров), то класс 1,5 означает, что  = 1,5% от длины шкалы.

= 1,5% от длины шкалы. очевидно, что ее значение растет обратно пропорционально

очевидно, что ее значение растет обратно пропорционально  и изменяется по гиперболе (рисунок 1.6), т.е. относительная погрешность равна классу точности СИ

и изменяется по гиперболе (рисунок 1.6), т.е. относительная погрешность равна классу точности СИ  лишь на последней отметке шкалы при

лишь на последней отметке шкалы при  .

. до значения

до значения  , относительная погрешность изменяется от

, относительная погрешность изменяется от  до

до  . Значение измеряемой величины

. Значение измеряемой величины  – называется порогом чувствительности. Эта величина ограничивает снизу полный диапазон

– называется порогом чувствительности. Эта величина ограничивает снизу полный диапазон  измеряемых величин. Верхняя граница

измеряемых величин. Верхняя граница  ограничена пределом измерения

ограничена пределом измерения  .

. , можно ограничить снизу рабочий диапазон

, можно ограничить снизу рабочий диапазон  (рисунок 1.6). Величина

(рисунок 1.6). Величина  назначается достаточно произвольно, учитывая, что обычно относительная погрешность в пределах рабочего участка шкалы

назначается достаточно произвольно, учитывая, что обычно относительная погрешность в пределах рабочего участка шкалы  не может превышать приведенную погрешность более чем в три раза. При меньших

не может превышать приведенную погрешность более чем в три раза. При меньших  шкала становится резко нелинейной и производить измерения на этом участке целесообразно перейдя на другой (меньший) диапазон измерения.

шкала становится резко нелинейной и производить измерения на этом участке целесообразно перейдя на другой (меньший) диапазон измерения. или относительной

или относительной  погрешности в данной точке

погрешности в данной точке  , то в этом случае выбор СИ, например, кл. 1 (

, то в этом случае выбор СИ, например, кл. 1 ( ) для измерения с относительной погрешностью ± 1% будет правилен, если верхний предел

) для измерения с относительной погрешностью ± 1% будет правилен, если верхний предел  СИ равен измеряемому значению

СИ равен измеряемому значению  величины. В остальных случаях абсолютную и относительную погрешность измерения с учетом чувствительности

величины. В остальных случаях абсолютную и относительную погрешность измерения с учетом чувствительности  необходимо определять по формулам

необходимо определять по формулам  и

и  .

. ,

, и

и  – соответственно, порог и предел чувствительности;

– соответственно, порог и предел чувствительности;  – относительная погрешность, ограничивающая снизу рабочий диапазон.

– относительная погрешность, ограничивающая снизу рабочий диапазон. Ом – 0,5 %;

Ом – 0,5 %;  Ом – 1 %;

Ом – 1 %;  Ом – 5 %;

Ом – 5 %;  Ом–10 %

Ом–10 % ;

;  Ом и

Ом и  Ом для любого

Ом для любого  относительная погрешность представлена на рисунке 1.6.

относительная погрешность представлена на рисунке 1.6.